文章目录

- 0 开始~

- 1 感知压缩的目的

- 2 自回归编码器-解码器生成模型一览

- 2.1 AE 自编码器

- 2.2 VAE 变分自编码器

- 2.3 VQ-VAE

- 2.4 VQ-GAN

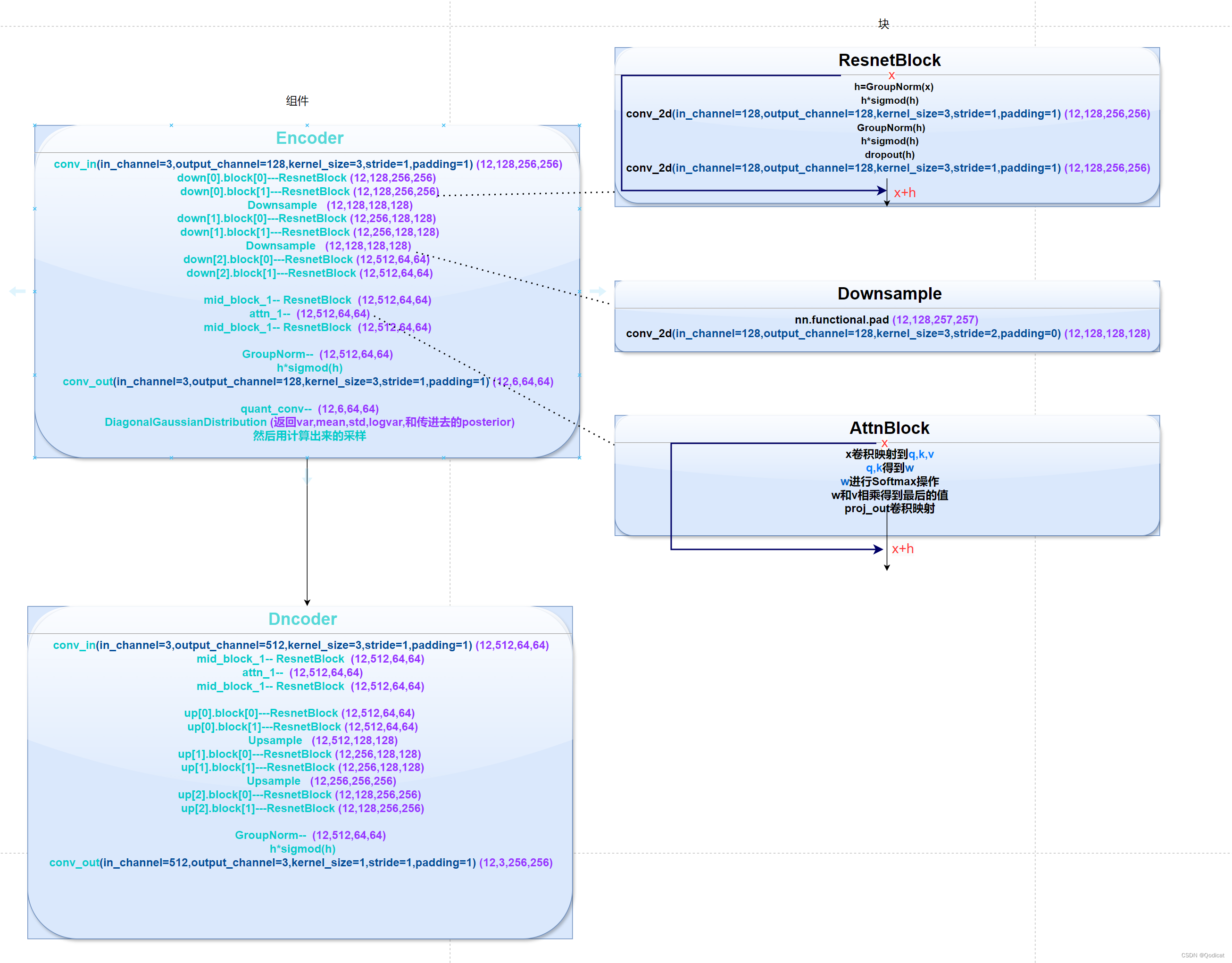

- 3 代码部分讲解总览

0 开始~

从今天起呢,我们会剖析LDM(潜在扩散模型)

从去年开始,大量的生成模型涌现出来

而你如果在阅读系列文章的时候,发现很多都是基于扩散模型的~

那么LDM在扮演着一个什么角色呢?

我认为

- 开创性:他是AIGC领域非常重要的模型之一,他将图像生成带到了一个新的高度,为Stable Diffusion这类经典开源AIGC模型奠定了基础

- 综合性:同时他也是一个很综合的模型,网上很多一些博客将VAE,GAN,扩散模型这些生成模型分割开来,但是从某种意义来说,你在LDM里面可以同时见到三种模型的影子,也就是说他集成了三类模型的智慧,怪不得他这么强~

- 传递性:他也是一个承前启后的模型,前有DDPM,DDIM等工作带火了扩散模型,后有如潜在一致性模型(LCM),ControlNet等模型,深入了解这一部分内容,方便我们更好地去了解AIGC模型大家族~

那么学习过程中可能会遇到什么问题呢?

首先最重要的是网络结构本身复杂,再者代码也不容易看懂,LDM代码是通过包含着大量的动态导入包,Pytorch_lighting框架实现,不是我们所熟悉的pytorch框架,因而会对代码阅读造成更大的困难~

我会从理论到代码实践全方位剖析LDM,方便大家后续的学习~

LDM是两阶段模型

- 第一阶段:对于图像进行压缩提取特征

- 第二阶段:压缩后在隐空间上进行扩散

我们首先讲LDM的第一阶段(代码中往往看到first_stage即这个阶段)图片压缩,实现从像素空间到隐空间的转换

1 感知压缩的目的

首先回答最重要的一个问题

为什么要进行像素空间的压缩?

- 同时压缩对应的可以减小之后扩散模型的计算量,高效快捷,原本像素空间比如是256*256*3 现在变成了16*16*3

具体怎么实现压缩的呢?

那就不得不提到我们的编码器-解码器家族系列了

2 自回归编码器-解码器生成模型一览

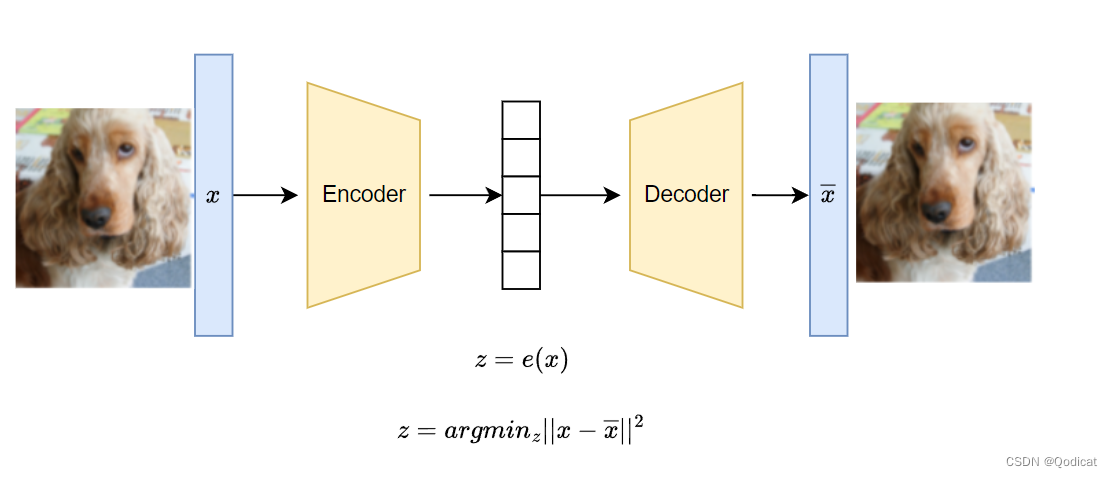

2.1 AE 自编码器

z = e ( x ) z=e(x) z=e(x)

AE (Auto-Encoder)即自编码器,是比较早提出进行图片压缩的

AE包含一个编码器和一个解码器。

训练时,输入图像 x x x会被编码成一个较短的向量 z z z,再被解码回和 x x x相同形状的 x ‾ \overline x x ,最小化 x x x和 x ‾ \overline x x 的差异,让重建出来的图像尽可能和原图相似 即 z = a r g m i n z ∣ ∣ x − x ‾ ∣ ∣ 2 z=argmin_z||x-\overline x||^2 z=argminz∣∣x−x∣∣2

解码器部分可以看做压缩,那么编码器部分就是一个生成模型呀!

所以我们只要拿到一个向量 z z z,就可以得到一个图片

但是问题来了,解码器只认得从编码器来的向量,而不认识其他向量,导致解码器不能很好的进行随机生成图片

所以VAE就来了~

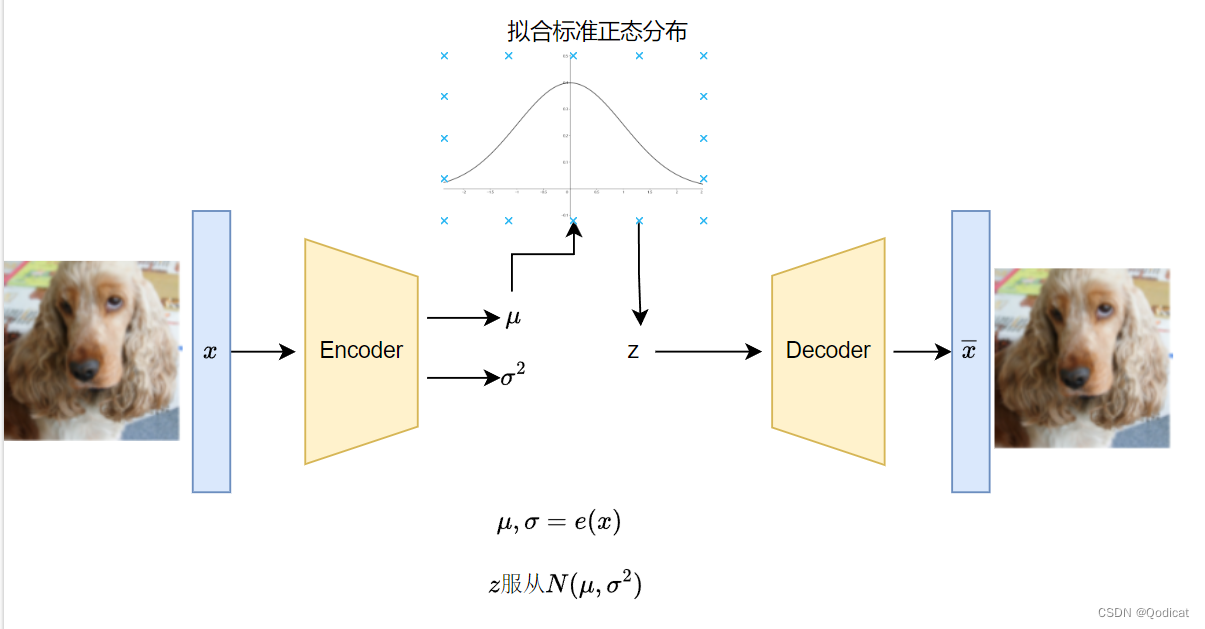

2.2 VAE 变分自编码器

AE距离生成图像就差一步,想一想,如果我们编码后的向量服从某一个规律,比如服从正态分布,那么这时候从这个正态分布随机采样一个向量,就可以生成图片了,这时候还可以生成一些多样的原本没有的图片

VAE就是如此

对于任意输入图像 x i x_i xi,VAE编码器会得到一个对应的均值和方差,对应的某一个正态分布就得到了

最后从这个正态分布采样得到隐变量 z z z传入生成器里面得到重构后的 x ‾ i \overline x_i xi 最小化 x x x和 x ‾ i \overline x_i xi 的差异,让重建出来的图像尽可能和原图 x i x_i xi相似

但是这里注意,如果我们就这样停止了,那么会有一个问题。模型为了恢复的更好,会将编码后的方差逐渐变为0(方差可以理解为噪声),这时候实际上就退化成了AE了,为了避免退化,VAE让编码后的向量尽可能服从0均值1方差

综上,接近标准正态分布的好处就是

1 我们可以从正态分布采样隐藏变量z,方便生成

2 避免退化为AE

训练完成后,我们就可以扔掉编码器,用来自标准正态分布的随机向量和解码器来实现随机图像生成了。

需要强调的是,VAE编码出来的向量是连续向量,也就是向量的每一维都是可能为任意小数,如1.154,1.342。如果把向量的某一维稍微改动那么一丢丢,解码器还是认得这个向量,并且会生成一张和原向量对应图片差不多的图片。

而之后的一些改进,如VQ-VAE就是离散的了,是量子化的,也就是说,只能是某些特定的离散的小数,比如1.1,1.2,1.3 不存在中间态

(科学空间有图)

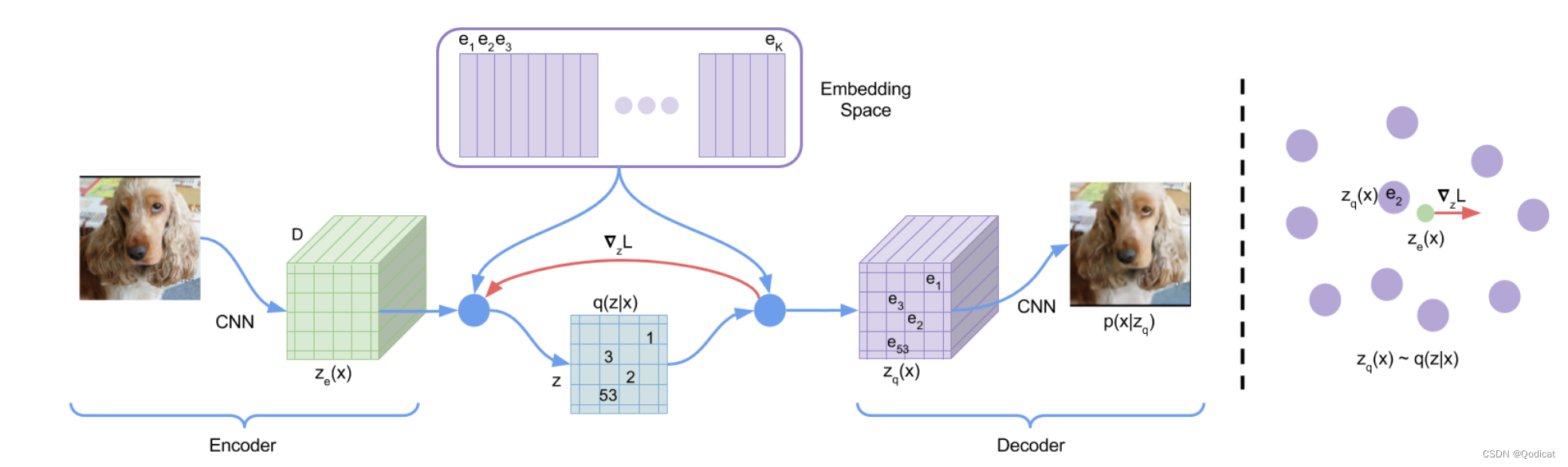

2.3 VQ-VAE

VQ-VAE提出codebook,并且进行离散编码

为什么要离散编码?

有几个直观理解

- 离散编码更自然,我们会说某一个人是男的还是女的,而不会说性别是0.5

- 虽然自然界的各种信号不论是图像还是语言,他都是连续的,但当我们处理这些问题时,往往是将问题离散化后再进行处理,如图像划分成像素、语音也是经过抽样

- 如果使用VAE的方式,样本的分布并不是很好学,VQ-VAE就使用了一个codebook去替代了VAE中学习样本分布的过程

预先生成一个离散数值的codebook,实际中可以通过(nn.Embedding实现)

我们假设codebook是 K × D K×D K×D 维的,其中 K K K 是指codebook的长度,一般设定为8192维,从0,1,2,3编号,而 D D D则是每一维向量的长度,一般设为512,codebook的长度 K K K可以简单的理解为codebook对应于 K K K个聚类中心。

1 将一张图片送入Encoder以后,会得到一个 H × W × D H×W×D H×W×D的 特征图 z e ( x ) z_e(x) ze(x)

2 将 H × W H×W H×W个 D D D维度向量和刚刚codebook的8192个分量计算相似度,找到最近的那一个分量的编号,最后可以得到 H × W H×W H×W的索引矩阵 q ( z ∣ x ) q(z|x) q(z∣x)

3 然后用索引对应向量去做替换原本的特征,得到新的特征图 p ( x ∣ z ) p(x|z) p(x∣z)该特征图作为Decoder的输入,最终通过Decoder得到重构后的图片。

离散向量的一个问题是它不好采样。回忆一下,VAE之所以把图片编码成符合正态分布的连续向量,就是为了能在图像生成时把编码器扔掉,让随机采样出的向量也能通过解码器变成图片。现在倒好,VQ-VAE把图片编码了一个离散向量,这个离散向量构成的空间是不好采样的。

这个问题是无解的。没错!VQ-VAE根本不是一个图像生成模型。它和AE一样,只能很好地完成图像压缩,把图像变成一个短得多的向量,而不支持随机图像生成。VQ-VAE和AE的唯一区别,就是VQ-VAE会编码出离散向量,而AE会编码出连续向量。

那怎么做生成?

就是通过其他网络,在压缩后的“小特征图”上做生成,比如用PixelCNN和扩散,生成后再用Decoder将“小特征图”翻译成最后的原图

轻松理解 VQ-VAE:首个提出 codebook 机制的生成模型 - 知乎 (zhihu.com)

VQ-VAE解读 - 知乎 (zhihu.com)

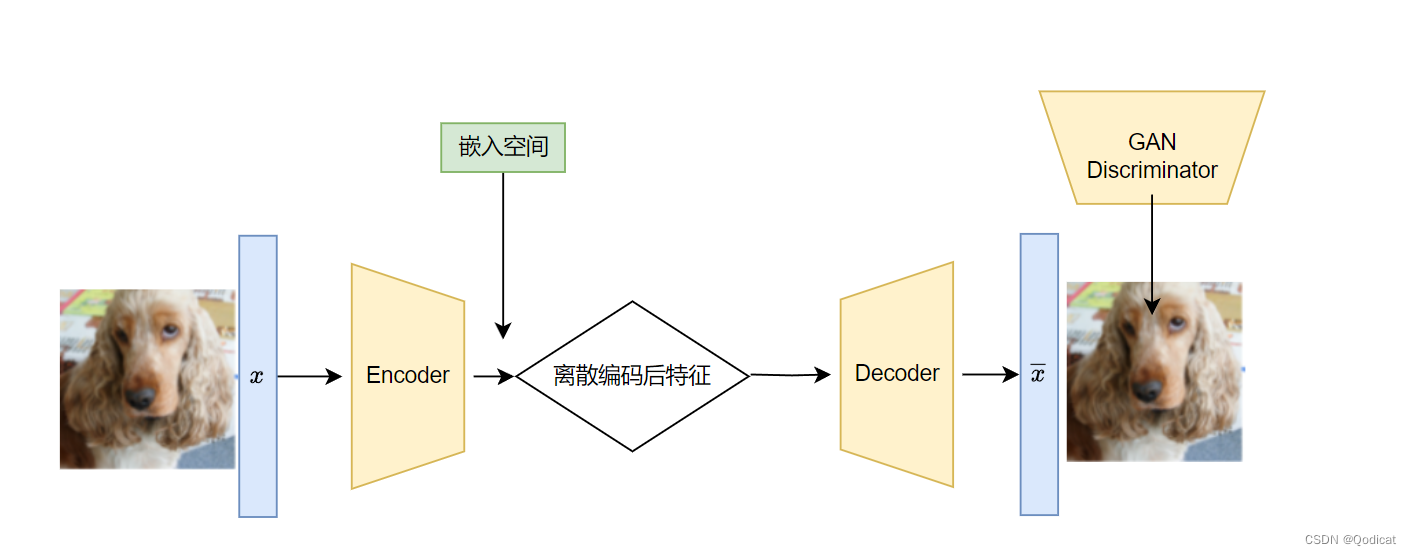

2.4 VQ-GAN

在VQ-VAE的损失函数的基础上

加入了对抗loss

当然,我们要注意:VQ-GAN也有重构损失,即也会缩小重构后的图像和原本的图像的差距~

详解VQGAN(一)| 结合离散化编码与Transformer的百万像素图像生成 - 知乎 (zhihu.com)

3 代码部分讲解总览

直接阅读的难点,我们刚刚提到了

网络结构本身复杂

所以我们给大家做了可视化

并且我们会从小到大依次给大家实现

先实现小的快,再实现更大的组件~