上一篇文章我们讨论了如何在本地运行大模型 。

安装本地大模型

大部分软件都需要安装,今天是免安装绿色版。

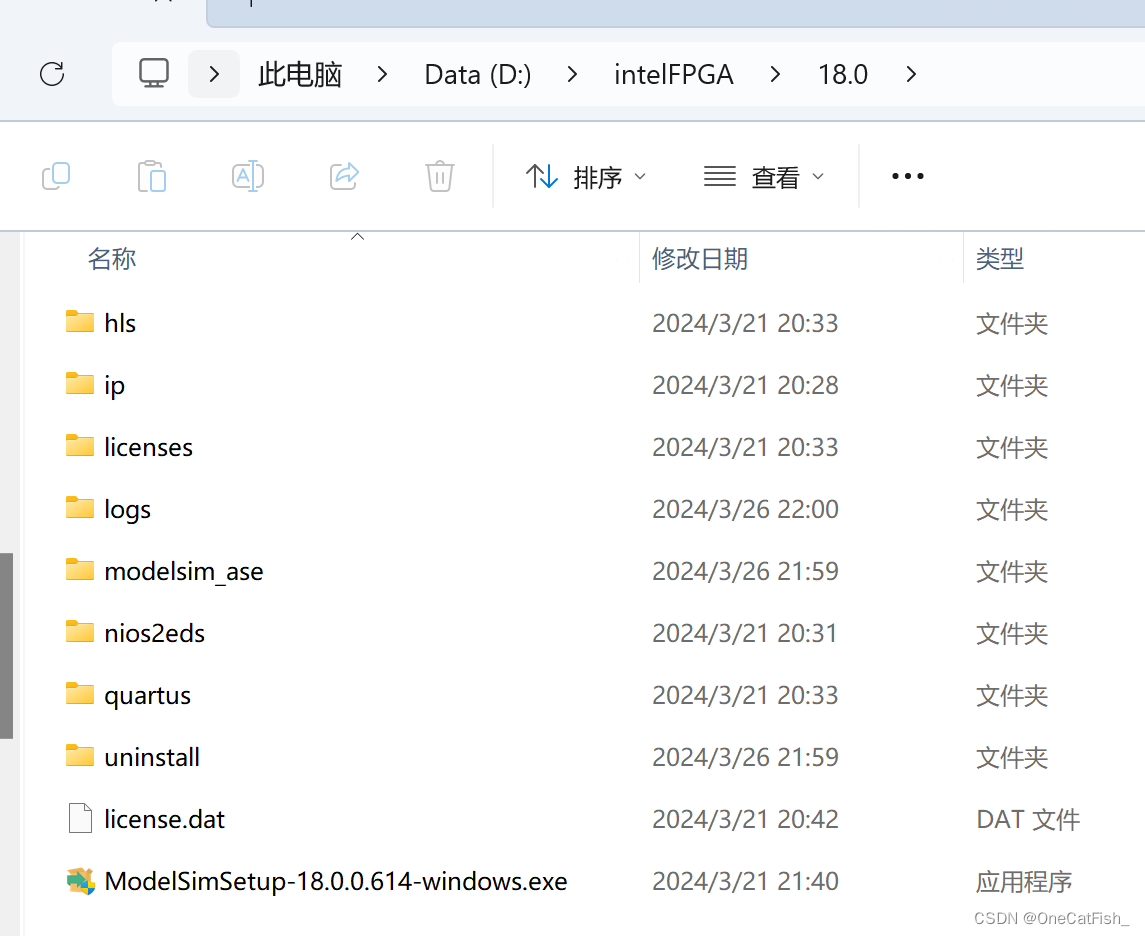

很多人下载不了原版,所以我放百度网盘了。

下载

-

下载:llava-1.5大模型(7b参数,流量警告:4G)

-

运行:.\llava-v1.5-7b-q4.llamafile -ngl 9999

-

结果:浏览器上输入 http://127.0.0.1:8080/

免安装的好处是不需要安装 docker,也不用安装多余软件,不想用了直接删除整个 exe 就干净了。

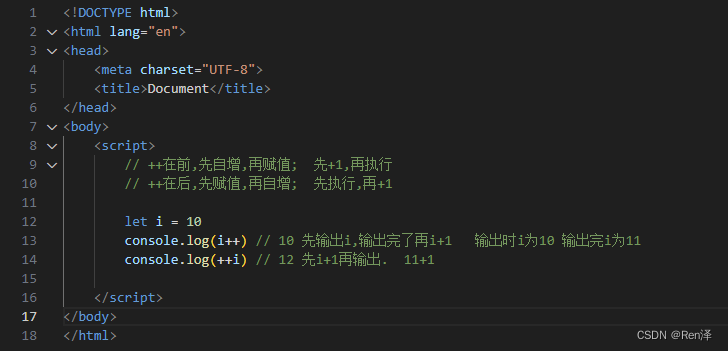

功能1:聊天

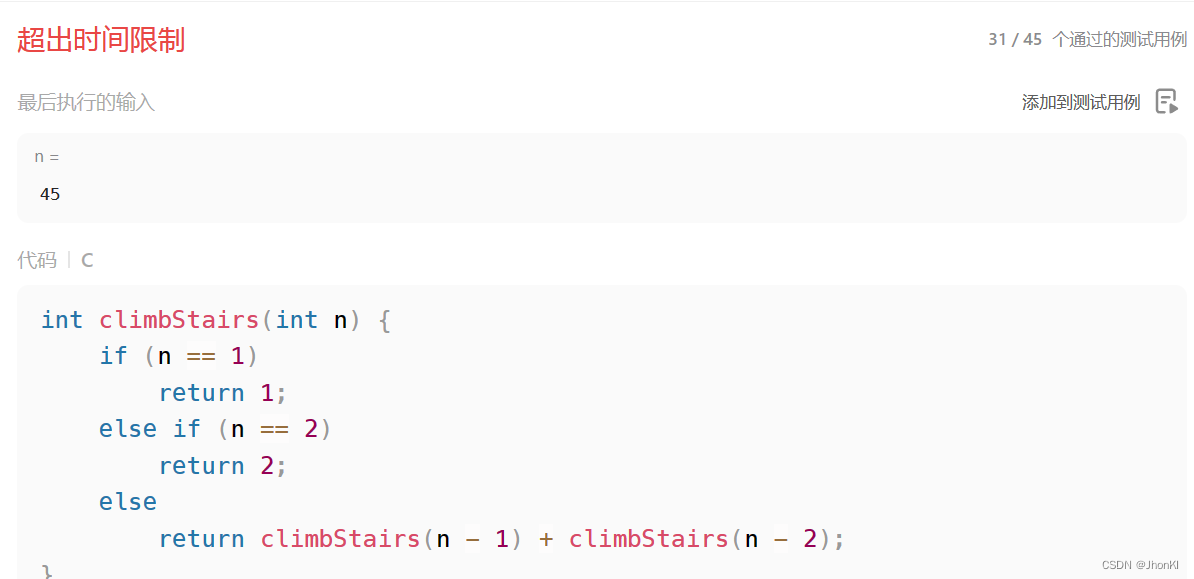

代码框架还行,聊天功能正常。

回答有一些帮助,但不多。毕竟参数只有 7b,但还是能让没搭建过大模型的小伙伴尝个鲜。

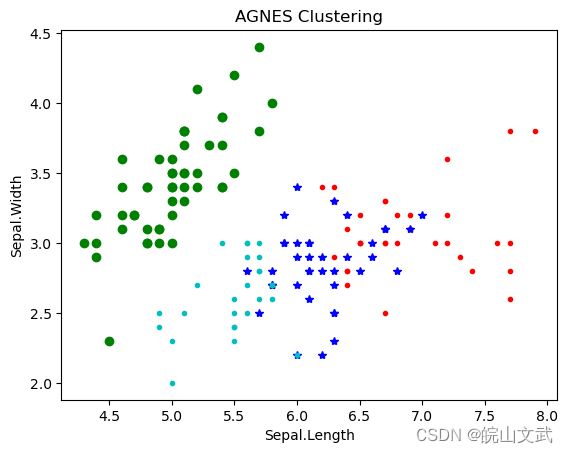

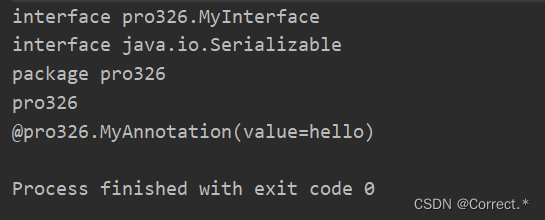

功能2:识别图片

这个提示词普通,不算坏,我用 SD 图生图(加了一些我自己写的负面提示词等)试了一下:

图片识别功能挺不错的,可以玩一玩。

目前略显粗糙,但效果还是不错的。以后也许可以用在图片识别领域。

这个 7B的大模型在我 32GB内存的台式机上运行绰绰有余。

正常来说13B的也能运行流畅,看我之前的文章就知道了。所以,如果有16GB的内存,也可以下载下来试一试。当然,配置越高越好。

结尾

这个大模型来自 llamafiles ,可在六种操作系统(macOS、Windows、Linux、FreeBSD、OpenBSD 和 NetBSD)上运行。

其余更好的大模型均在 https://github.com/Mozilla-Ocho/llamafile?tab=readme-ov-file 可下载。