文章目录

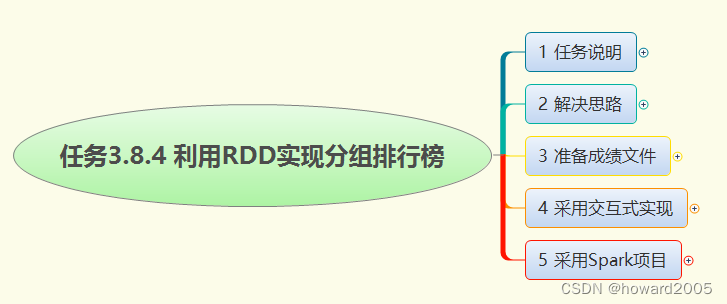

- 1. 任务说明

- 2. 解决思路

- 3. 准备成绩文件

- 4. 采用交互式实现

- 5. 采用Spark项目

- 实战概述:使用Spark RDD实现分组排行榜

- 任务背景

- 任务目标

- 技术选型

- 实现步骤

- 1. 准备数据

- 2. 数据上传至HDFS

- 3. 启动Spark Shell

- 4. 读取数据生成RDD

- 5. 数据处理

- 6. 计算TopN

- 7. 输出结果

- 8. 采用Spark项目实现

- 代码实现

- 结果展示

- 总结

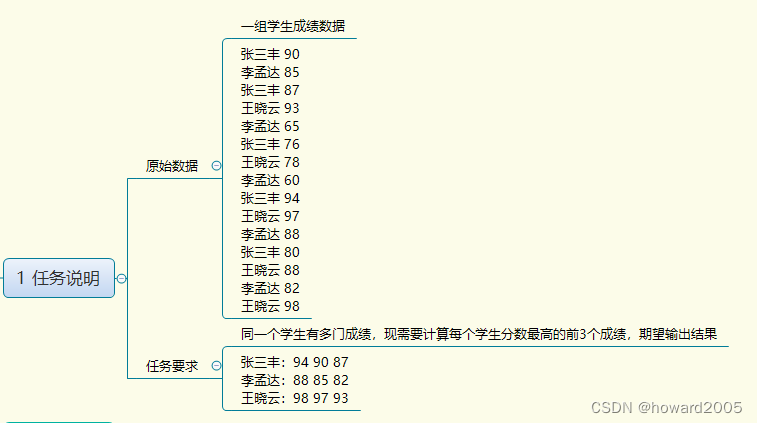

1. 任务说明

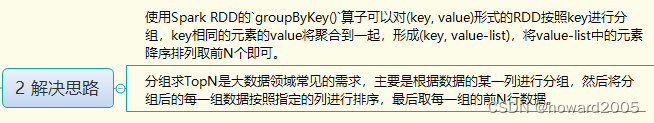

2. 解决思路

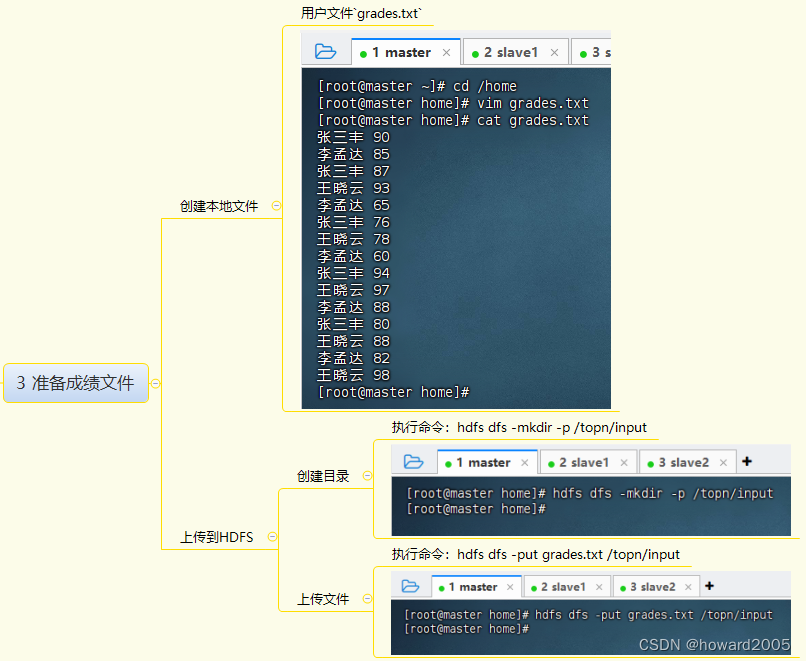

3. 准备成绩文件

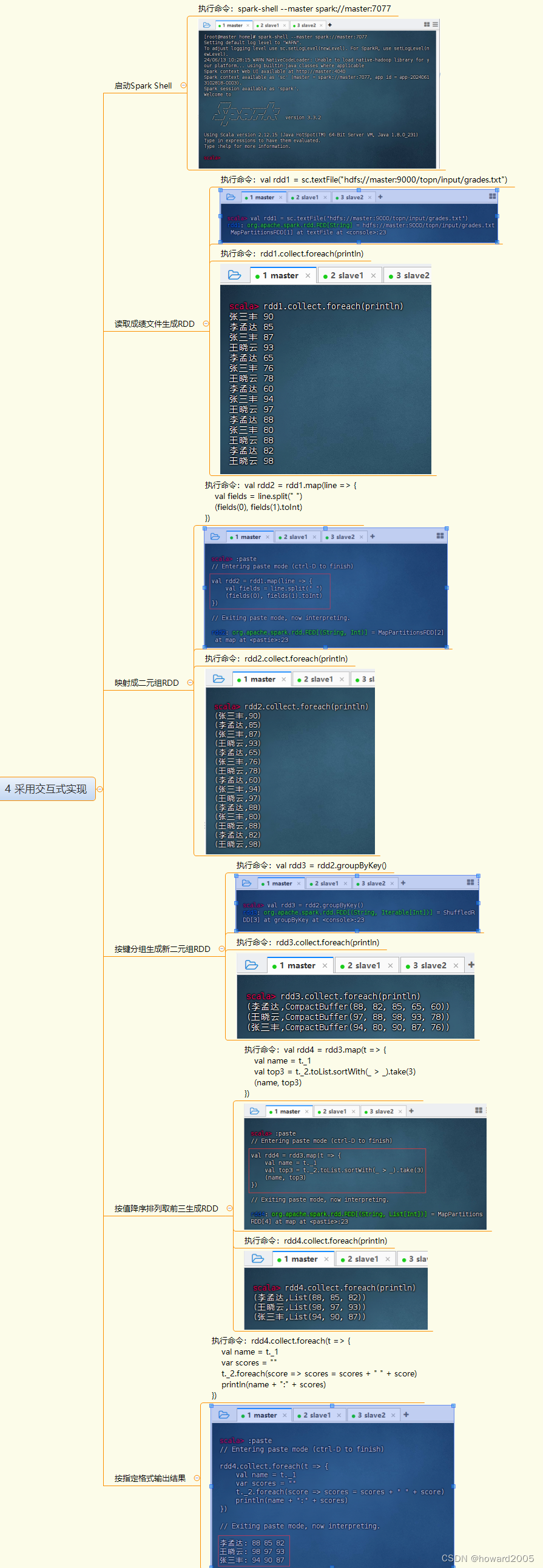

4. 采用交互式实现

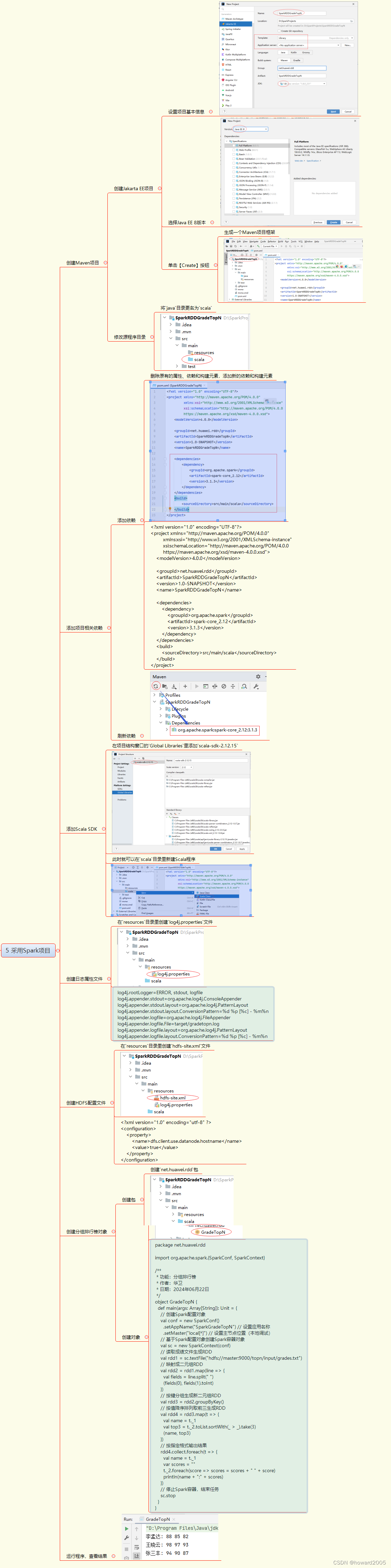

5. 采用Spark项目

实战概述:使用Spark RDD实现分组排行榜

任务背景

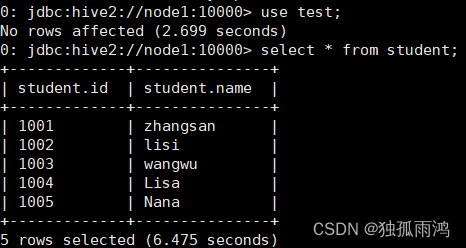

在大数据环境下,经常需要对数据进行分组和排序操作。本实战任务旨在利用Apache Spark的RDD(弹性分布式数据集)来实现对学生成绩数据的分组,并求出每个学生分数最高的前3个成绩。

任务目标

- 处理学生成绩数据,每个学生有多条成绩记录。

- 对每个学生的成绩进行分组。

- 计算每个学生分数最高的前3个成绩。

- 输出格式化的排行榜结果。

技术选型

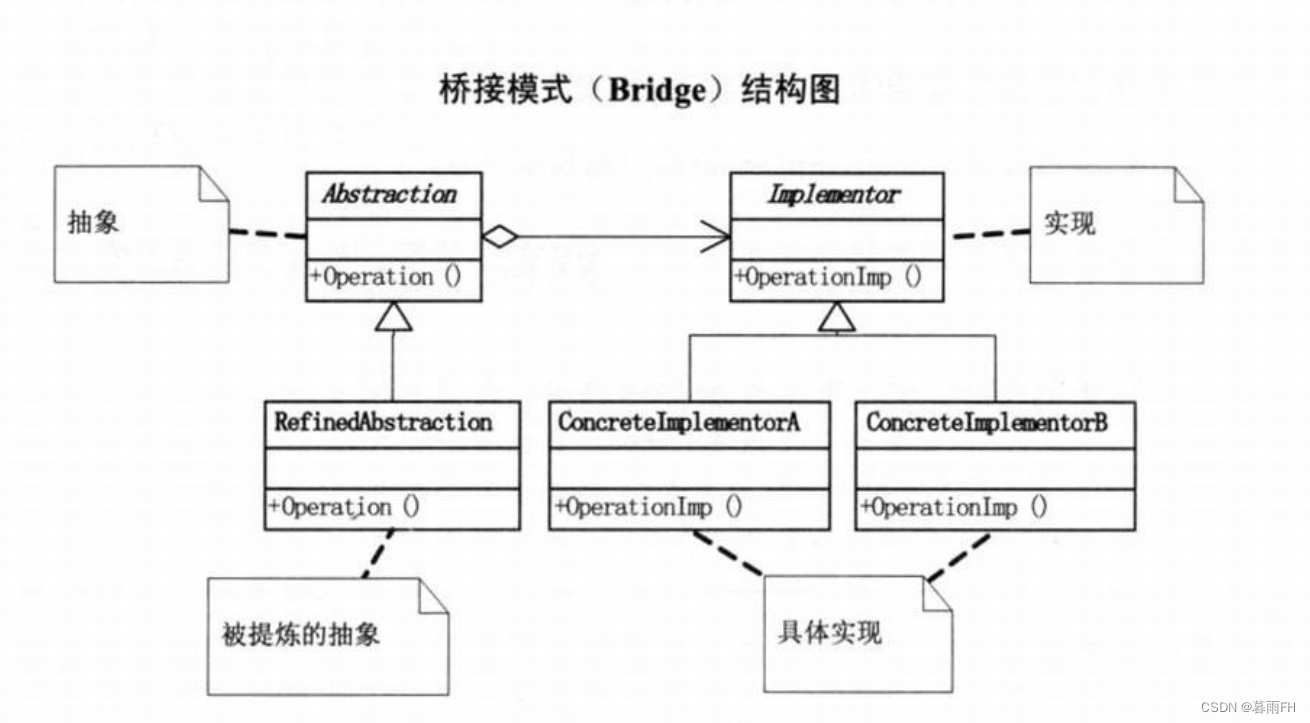

- 使用Apache Spark作为大数据处理框架。

- 利用Scala语言进行编程实现。

实现步骤

1. 准备数据

- 创建本地文件

grades.txt,包含学生姓名和对应的成绩。

2. 数据上传至HDFS

- 创建HDFS目录

/topn/input。 - 将

grades.txt上传至HDFS。

3. 启动Spark Shell

- 执行命令

spark-shell --master spark://master:7077启动Spark Shell。

4. 读取数据生成RDD

- 使用

sc.textFile读取HDFS上的成绩文件,生成RDD。

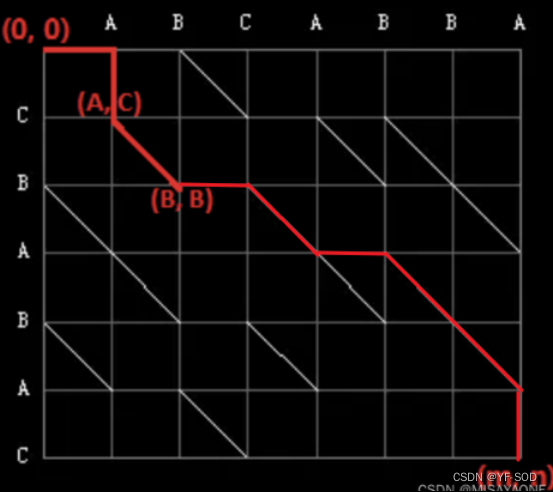

5. 数据处理

- 将每行数据映射为(key, value)形式的二元组,其中key为学生姓名,value为成绩。

- 使用

groupByKey对RDD中的元素按照key进行分组。

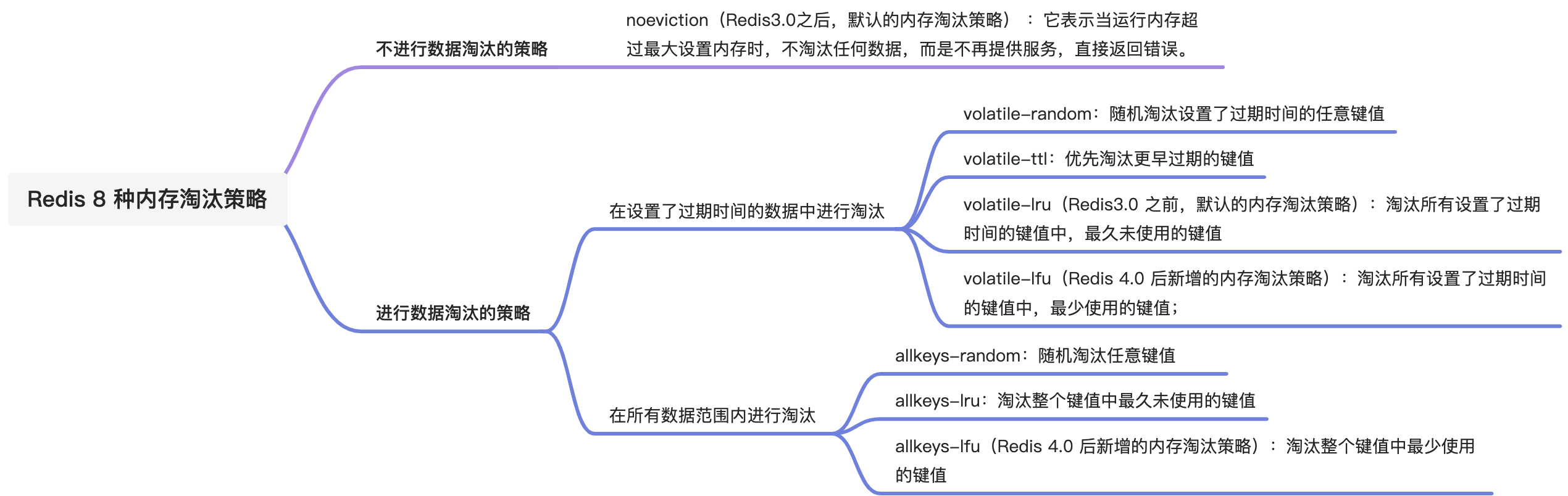

6. 计算TopN

- 对每个分组的value列表进行降序排序,并取前3个元素。

7. 输出结果

- 格式化输出每个学生的Top3成绩。

8. 采用Spark项目实现

- 创建Maven项目,添加Spark依赖。

- 添加Scala SDK。

- 创建日志和HDFS配置文件。

- 编写Scala程序实现上述数据处理逻辑。

- 运行程序并查看输出结果。

代码实现

以下是使用Scala编写的Spark程序示例,用于实现分组排行榜功能:

package net.huawei.rddimport org.apache.spark.{SparkConf, SparkContext}object GradeTopN {def main(args: Array[String]): Unit = {val conf = new SparkConf().setAppName("SparkGradeTopN").setMaster("local[*]")val sc = new SparkContext(conf)val rdd1 = sc.textFile("hdfs://master:9000/topn/input/grades.txt")val rdd2 = rdd1.map(line => line.split(" ") match {case Array(name, score) => (name, score.toInt)})val rdd3 = rdd2.groupByKey()val rdd4 = rdd3.mapValues(_.toList.sortBy(-_).take(3))rdd4.foreach(t => println(s"${t._1}:${t._2.mkString(" ")}"))sc.stop()}

}

结果展示

程序运行后,将输出每个学生的Top3成绩

张三丰:94 90 87

李孟达:88 85 82

王晓云:98 97 93

总结

本实战任务展示了如何使用Spark RDD对数据进行分组和TopN计算,这是大数据领域中常见的数据处理需求。通过Spark的强大数据处理能力,可以高效地完成此类任务。