如何通过✅ IPIDEA代理IP,轻松实现数据采集和市场拓展工作

- 如何通过✅ IPIDEA代理IP,轻松实现数据采集和市场拓展工作

- 前言

- IPIDEA爬虫实战

- 实战Demo演示

- 总结

如何通过✅ IPIDEA代理IP,轻松实现数据采集和市场拓展工作

前言

在当今全球化市场的浪潮中,跨境电商和数据采集已经成为了企业发展的重要驱动力。然而,随着网络环境的复杂化,如何保证数据的高效采集和交易的安全性,成为了每个企业必须面对的难题。而代理IP,正是解决这些问题的关键工具。本文将深度剖析代理IP在跨境电商和数据采集中的重要性,详细介绍IPIDEA的优势与实际应用。

IPIDEA爬虫实战

接下来我们开始使用IPIDEA代理:

-

点击链接登录[官网],如果没有账号大家需要进行注册下;

-

我们点击下面的注册按钮进行注册;

-

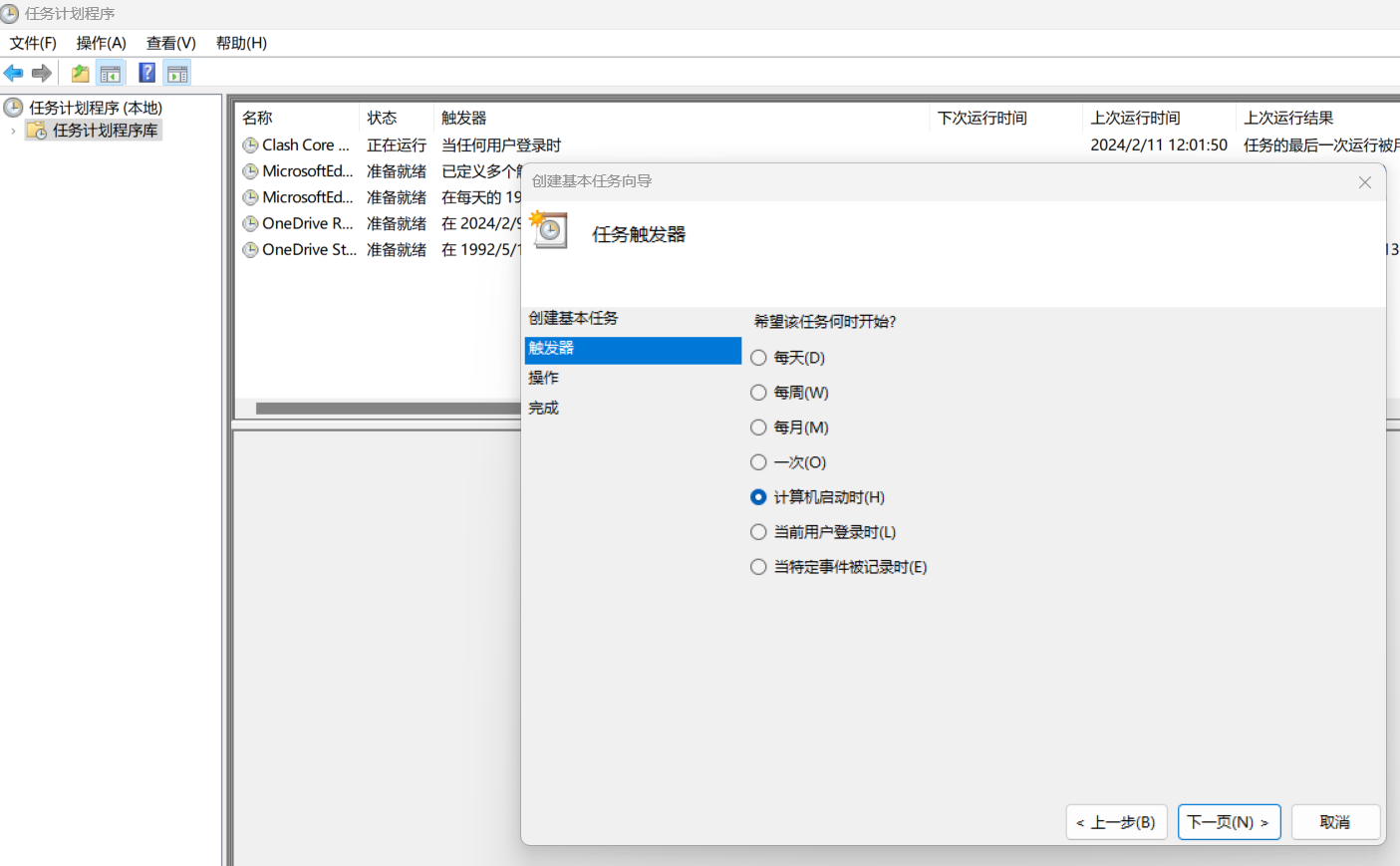

我们登录进入IPIDEA的主页,如下图;

-

我们先在代理管理器中 把本地IP加入到白名单中;

- 打开IPIDEA的API生成我们的IP;

-

打开链接就可以看到我们刚才生成的IP;

-

同时,我们也可以通过账号密码的形式获取。我们需要创建一个账号,来生成我们的账号密码等信息;

-

确定之后就生成如下图的账号名和密码了;账号记得用认证账号;账号名有后缀,需要去除;

我们在上面的操作中可以得到,账号和密码及其地址,下面实战中我们就可以进行使用了;

实战Demo演示

- 下面是我们使用python爬虫技术,提取本地主页的一个程序;代码示例如下:我们这里省去了账号信息;

在使用下面python的时候,我们需要写安装相关的依赖:

playwright install # 安装python的依赖

import asyncio

from playwright.async_api import async_playwrightAUTH = '账号:密码

PROXY_URL = '地址:端口'async def run(pw):print('Launching browser with proxy...')browser = await pw.chromium.launch(proxy={'server': f'http://{PROXY_URL}','username': AUTH.split(':')[0],'password': AUTH.split(':')[1]})try:print('Browser launched! Navigating to test URL...')context = await browser.new_context()page = await context.new_page()await page.goto('https://www.amazon.com/s?i=specialty-aps&bbn=16225009011&rh=n%3A%2116225009011%2Cn%3A281407&language=zh&ref=nav_em__nav_desktop_sa_intl_accessories_and_supplies_0_2_5_2', timeout=4 * 60 * 1000) # 增加超时时间print('Navigated! Scraping page content...')html = await page.content()print(html)except Exception as e:print(f"Failed to navigate: {e}")# 尝试访问其他URL以进行测试try:await page.goto('', timeout=4 * 60 * 1000)print('Successfully navigated to example.com!')html = await page.content()print(html)except Exception as e:print(f"Failed to navigate to example.com: {e}")finally:await browser.close()async def main():async with async_playwright() as playwright:await run(playwright)if __name__ == '__main__':asyncio.run(main())执行上面的代码就可以看到测试数据了;成功获取了亚马逊的网站的数据;并成功获取了网站数据;

2. 下面我们使用Playwright和代理服务器来测试多个国外网站的访问性能和稳定性。通过代理服务器发起网页请求,测试代理服务器在不同网站上的表现,并记录访问结果和页面内容;同理下面也省去了账号信息;

import asyncio

from playwright.async_api import async_playwrightAUTH = '账号:密码

PROXY_URL = '地址:端口'TEST_URLS = ['https://www.amazon.com/s?i=specialty-aps&bbn=16225009011&rh=n%3A%2116225009011%2Cn%3A281407&language=zh&ref=nav_em__nav_desktop_sa_intl_accessories_and_supplies_0_2_5_2','https://www.yahoo.com', #Yahoo'https://github.com' #GitHub

]async def test_proxy(page, url):"""测试代理IP在指定URL上的表现"""try:print(f'Navigating to {url}...')await page.goto(url, timeout=4 * 60 * 1000) # 增加超时时间print(f'Successfully navigated to {url}!')html = await page.content()print(html[:500]) # 仅打印前500个字符except Exception as e:print(f"Failed to navigate to {url}: {e}")async def run(pw):"""启动浏览器并测试多个URL"""print('Launching browser with proxy...')browser = await pw.chromium.launch(proxy={'server': f'http://{PROXY_URL}','username': AUTH.split(':')[0],'password': AUTH.split(':')[1]})try:print('Browser launched! Creating new browser context...')context = await browser.new_context()page = await context.new_page()for url in TEST_URLS:await test_proxy(page, url)finally:await browser.close()print('Browser closed.')async def main():async with async_playwright() as playwright:await run(playwright)if __name__ == '__main__':asyncio.run(main())

通过我们上面的代码,可以看出代理服务器在访问Amazon、Yahoo和GitHub时表现良好,能够成功加载页面并获取内容。代理能够正确处理这些网站的请求,说明其性能和稳定性在这些情况下是令人满意的。

3.使用 IPIDEA 爬取页面

下面我们使用Playwright来爬取页面并保存,首先我们先需要安装下环境必备的依赖

在电脑cmd中分别执行如下命令即可:

pip install playwright

pip install pillow

playwright install

#pip install playwright

#pip install pillow

#playwright installimport asyncio

from playwright.async_api import async_playwrightAUTH = '账号:密码

PROXY_URL = '地址:端口'URL = 'https://www.bbc.com/' #此次比bbc为例 需要爬取的网页URL

IMAGE_PATH = 'moyu.png' # 保存截图的路径async def capture_screenshot(pw):print('Launching browser with proxy...')browser = await pw.chromium.launch(proxy={'server': PROXY_URL,'username': AUTH[0],'password': AUTH[1]})try:print('Browser launched! Navigating to URL...')context = await browser.new_context()page = await context.new_page()await page.goto(URL, timeout=4 * 60 * 1000) # 增加超时时间print('Navigated! Capturing screenshot...')await page.screenshot(path=IMAGE_PATH, full_page=True) # 保存整个页面的截图print(f'Screenshot saved to {IMAGE_PATH}')except Exception as e:print(f"Failed to capture screenshot: {e}")finally:await browser.close()async def main():async with async_playwright() as playwright:await capture_screenshot(playwright)if __name__ == '__main__':asyncio.run(main())

我们通过测试可以看出成获取了bbc网站的信息;并转为图片.如上图,正是近期举行的巴黎奥运会的信息;

通过以上DEMO实战,我们可以明显看到,IPIDEA在处理网页截图和测试代理性能等方面表现出色。这些代码都能有效地展示它的强大功能和灵活性。凭借这些功能,我们能够轻松实现网页数据的抓取和展示,充分证明了IPIDEA代理在实际应用中的可靠与稳定。

总结

我们通过上面的对IPIDEA的介绍和实战,得出[IPIDEA]是一款及其稳定可靠的服务拥有丰富的IP资源,对于出海企业而言,这是一个无法忽视的优质选项。通过本文的介绍,希望能够帮助大家更好地理解代理IP的优势,并在实际应用中发挥其最大效能。

![[ BLE4.0 ] 伦茨ST17H66开发-串口UART0的接收与发送](https://i-blog.csdnimg.cn/direct/296a62cd199e45f7a775781da85d7c26.png)