作者:Gabriel Goh, Chelsea Voss, Daniela Amodei, Shan Carter, Michael Petrov, Justin Jay Wang, Nick Cammarata, and Chris Olah

翻译:欧阳锦 校对:王可汗本文约4000字,建议阅读12分钟本文探讨了OpenAI在CLIP模型中发现人类大脑多模态神经元的发现,并对这项发现进行了深入的思考和研究。

标签:神经网络 通用人工智能 语言模型

OpenAI最近在CLIP神经网络上发现了神经元。无论这是字面意义、象征意义还是概念上的表示,这些神经元都对相同的概念做出反应。这个发现或许可以解释CLIP在对令人惊讶的视觉化概念分类时的准确度。同时,这种发现让人们向理解CLIP和其他类似模型在训练过程中学习到的关联和偏差迈出了重要的一步。

内容

CLIP中的多模态神经元

不存在的概念(concepts)

多模态神经元的构成

抽象(abstraction)的悖论

野生攻击

偏差与过度泛化

总结

十五年前,Quiroga等人1发现人类大脑中拥有多模态神经元。这些神经元会对围绕着一个高级主题的抽象概念(而不是对特定视觉特征的抽象概念)做出反应。其中,最著名的当属“Halle Berry”神经元,这是一个被《科学美国人》和《纽约时报》都使用过的例子。这个神经元只对美国女演员“Halle Berry”的相片、草图、文字做出反应。

《科学美国人》

https://www.scientificamerican.com/article/one-face-one-neuron/

《纽约时报》

https://www.nytimes.com/2005/07/05/science/a-neuron-with-halle-berrys-name-on-it.html

两个月前,OpenAI发布了CLIP,这是一个可与ResNet-50 2表现力相比肩的通用视觉系统。不仅如此,在一些具有挑战性的数据集上,CLIP的表现超过了现有的视觉系统。这些具有挑战的数据集(ObjectNet,ImageNet Rendition和ImageNet Sketch)均对模型的鲁棒性进行了压力测试,不仅要识别简单的变形、光照或姿势变化,还要完成对物体(无论是以草图、卡通或雕塑的形式出现)的抽象和重建。

CLIP

https://openai.com/blog/clip/

现在,OpenAI要发布关于CLIP中存在多模态神经元的发现。举个例子,一个“Spider-Man”神经元(与“Halle Berry”神经元类似),它会对蜘蛛的图像,对标注了“spider”文字的图像,以及漫画人物“蜘蛛侠”的服装或插图做出反应。

OpenAI在CLIP中发现的多模态神经元为这些研究人员提供了线索——抽象是合成视觉系统与自然视觉系统中的普遍机制。由此,他们发现CLIP的最高层将图像组织为“ideas”的松散语义集合,这些集合从而对模型的通用性和表现形式的紧凑性做出了简单解释。

生物神经元,诸如著名的“Halle Berry“”神经元不会激发“ideas”的视觉集群,而是激发语义集群。在CLIP的最高层,研究人员发现了相似的语义不变性。请注意,这些图像被Quiroga等人1的高分辨率图片替代,Quiroga等人的这些高分率图片本身就是原刺激的替代。

OpenAI使用可解释性工具,对CLIP权重之内的丰富视觉概念进行了史无前例的研究。他们在CLIP中发现了涵盖人类视觉词典大部分的高级概念,包括地理区域、面部表情、宗教图像、名人等。通过探究每个神经元的后续影响力,我们可以对CLIP如何执行分类任务加深了解。

CLIP中的多模态神经元

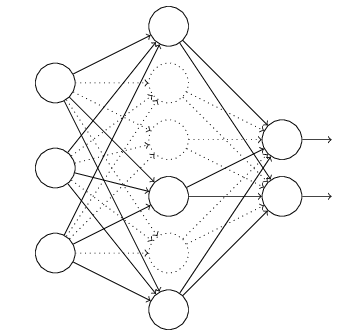

本文建立在近十年来对卷积网络解释3,4,5,6,7,8,9,10,11,12的研究基础上,本研究首先观察到许多经典技术可以直接用于CLIP。OpenAI使用了两种工具对模型激活进行理解:特征可视化6,5,12(feature visualization)和数据集示例4(dataset examples)。前者是通过对输入进行基于梯度的优化最大化神经元的激活;后者则是观察一个数据集中一个神经元最大激活图像的分布。

使用这些简单的技术,研究者们发现CLIP RN50x4(ResNet-50 利用 EfficientNet 扩展规则扩增 4 倍)中的大多数神经元都可以被轻易地解释。然而,这些神经元似乎是“多面神经元(multi-faceted neurons)” 11的极端示例,即这些神经元仅在更高的抽象水平下对不同示例做出反应。下面的图片展示了它们的区别:

由神经元(Neuron)展示的不同效果

由多面神经元(Facet Neuron)展示的效果

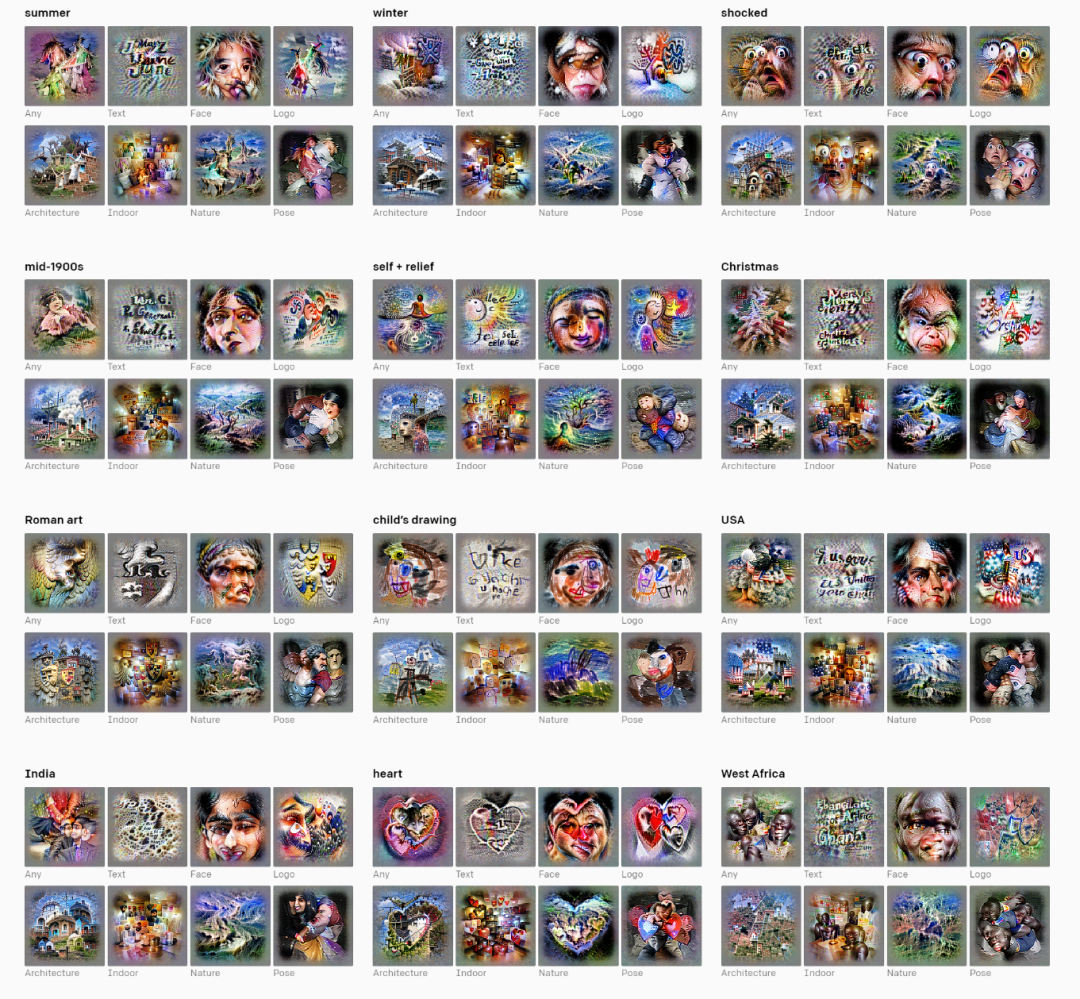

选择的神经元来自四个CLIP模型的最后一层。每个神经元由带有人为选择的概念标签的特征可视化进行表示,这些标签为快速提供每个神经元的感觉提供帮助。不仅是特征可视化,这些标签是在查看激活神经元的数百种刺激后被选择的。我们在这里通过一些例子说明了模型对区域、感情和其他概念的刻板描述倾向。除此之外,我们还看到了神经元分辨率水平的差异:虽然某些国家(如美国和印度)与定义明确的神经元有关,但非洲国家的情况并非如此。在非洲,神经元倾向于在整个地区进行激活。这部分偏差及其含义将在后面的部分中进行讨论。

的确,研究人员惊讶地发现了例子中许多类别似乎反映了带有颅内深度电极记录的癫痫患者内侧颞叶中的神经元。这些神经元包含了那些对情绪17、动物18和名人1做出反应的神经元。

但是,研究人员对CLIP的研究揭示了更多这样奇妙的抽象,它们包括了似乎可以计数的神经元[17,202,310],对艺术风格做出反应的神经元[75,587,122],甚至对具有处理痕迹的图像做出反应的神经元[1640]号。(请在原文中对这些神经元进行进一步查看)

不存在的概念

尽管这个分析显示了概念的广泛程度,但OpenAI的研究人员注意到,在神经元级别上进行的简单分析不能代表模型行为的完整记录。例如,CLIP的作者证明了该模型能够进行非常精确的地理位置定位19(Appendix E.4,Figure 20),其粒度可以扩展到城市甚至社区的级别。这里有一个趣事:如果通过CLIP运行自己的个人照片,研究人员注意到CLIP经常可以识别出照片是否是在旧金山,或者其附近(例如“双子峰”)拍摄的。

尽管尽了最大的努力,但是研究人员还没有找到“San Francisco”神经元,从归因上看,旧金山(“San Francisco”)似乎也没有很好地分解成像加州和城市这样有意义的单元概念。我们相信这些信息被编码在模型激活的某个地方,但以一种更奇特的方式,要么是一个方向,要么是其他一些更复杂的流形。我们相信这是一个值得进一步研究的方向。

多模态神经元的构成

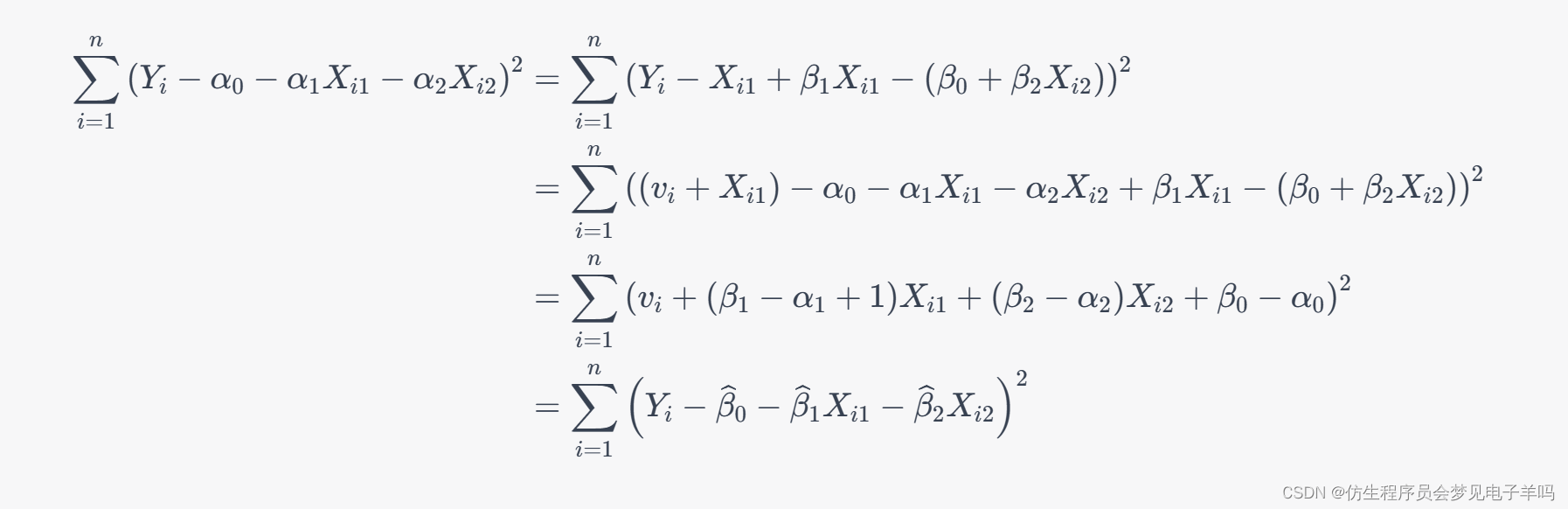

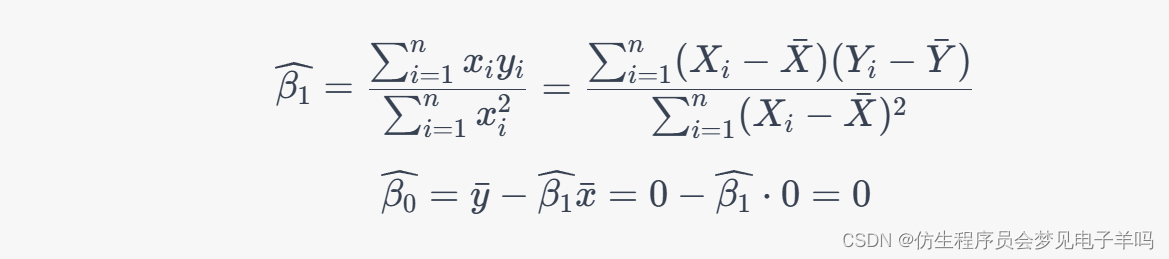

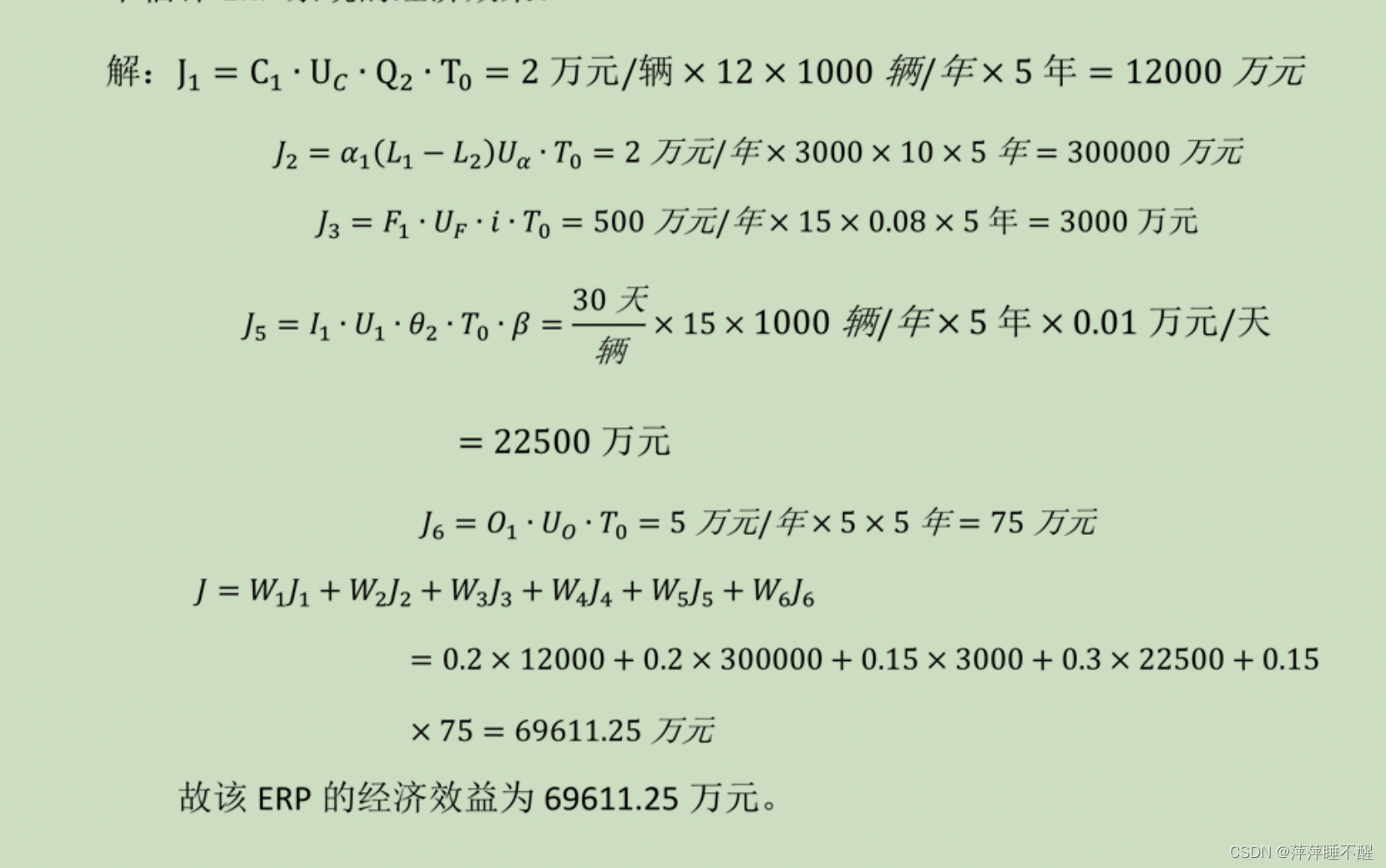

这些多峰神经元可以帮助人们深入了解CLIP是如何执行分类的。使用一个稀疏线性探针19,研究人员能够轻松地检查CLIP的权重,进而观察哪些概念结合在一起实现了ImageNet数据集的最终分类:

如上图,存钱罐类别似乎是“finance”神经元和瓷器(porcelain)神经元的组合。前文提到的“Spider-Man”侠神经元也是一个蜘蛛(spider)检测器,在“barn spider”(谷仓蜘蛛)类别的分类中起到了重要作用。

对于文本分类,研究人员的一个重要发现是,这些概念以类似于word2vec目标函数20的形式包含在神经元中,它们几乎是线性的。因此,这些概念组成了一个简单的代数形式,其行为与线性探针类似。通过线性化注意力,研究人员也可以像线性探针一样检查任何句子,如下所示:

在探究CLIP如何理解单词的过程中,模型似乎发现“surprised”一词不仅暗示了某种程度的震惊,而且还包含了一种形式非常特殊的“震惊”,其可能与“喜悦”或“惊异”结合在一起。“Intimate”则包含了柔和的笑容和内心,但不包括疾病(sickness)。研究人员还注意到,对“intimate”的理解揭示了人类对亲密关系完整体验的还原性理解——排除疾病(例如,与生病的亲人的亲密时光被排除在外)。在探究CLIP对语言的理解时,研究人员发现了很多类似的排除和遗漏。

抽象(abstraction)的悖论

CLIP中的抽象程度揭示了一个新的攻击向量(vector of attack),OpenAI认为攻击向量在以前的系统中并未表现出来。如同其他深度网络,CLIP最高层的表征完全由这种高级抽象控制。但是CLIP的与众不同在于其程度(degree)—— CLIP的多模态神经元泛化(generalize)范围从文字覆盖到符号,而这可能是一把双刃剑。

通过一系列精心构建的实验,研究人员证明了人类可以利用这种还原行为来欺骗模型,使之进行荒谬的分类。研究人员已经观察到,CLIP中神经元的激发通常可以通过其对文本图像(images of text)的反应来控制,从而为攻击模型提供了一个简单的(攻击)向量。

例如,金融(finance)神经元[1330]号对存钱罐的图像做出反应,但也对字符串“ $$$”做出反应。通过强迫激活1330号神经元,研究人员可以欺骗模型,并将狗分类为存钱罐。

如上图所示,通过在图像上渲染文本,研究人员人为地刺激了1330号神经元,该神经元在线性探针的“存钱罐(piggy bank)”类中具有很高的权重。这导致分类器将贵宾犬错误地分类为存钱罐。

野生攻击

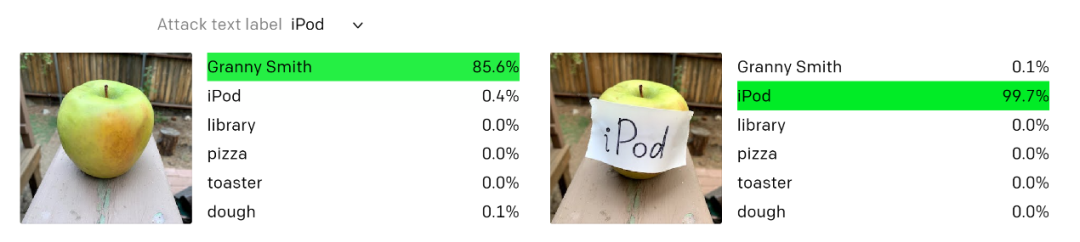

OpenAI将这些攻击称为排版攻击(typographic attacks)。 研究人员认为如上所述的攻击绝不仅仅与学术相关。研究人员发现,通过利用模型强大的读取文本的能力,即使是手写文本的照片(photographs of hand-written text)也常常会欺骗模型。像对抗补丁(Adversarial Patch)21一样,该攻击属于野生攻击;但与对抗补丁不同的是,排版攻击只需要笔和纸即可。

当研究人员在这个Granny Smith(苹果的一个种类)苹果上贴一个标有“iPod”的标签时,在零次学习(zero-shot)设置中,该模型会错误地将其归类为iPod。

OpenAI还认为,这些攻击也可能采取更微妙的、不太引人注目的形式。当那些提供给CLIP的图像以许多微妙而复杂的方式抽象,这些抽象可能会过度抽象常见的模式——即过于简化,并因此而发生过度泛化的情况。

偏差与过度泛化

尽管CLIP模型是在精心挑选的互联网子集上进行训练的,但它仍然继承了其许多不受控制的偏差和关联。研究人员发现许多关联似乎是良性的,但是CLIP也包括几种可能导致很大损害的关联,例如,对某些特定人群或团体的诋毁。

例如,研究人员已经观察到“Middle East”神经元[1895]号与恐怖主义有关;“immigration”神经元[395]号对拉丁美洲产生反应。研究人员甚至发现了一个对黑皮肤人群和大猩猩都产生反应的神经元[1257]号。这些都反映了那些人们不可接受的早期其他模型中存在的图像标注问题22。

这些关联对此类强大的视觉系统的应用提出了极大的挑战[1]。无论是微调还是使用零样本学习(zero-shot),这些偏差和关联都很可能会保留在系统中,它们也会以可见和几乎不可见的方式影响部署过程。许多偏差行为可能很难被提前预测,进而测量和校正这些偏差也变得困难。研究人员认为,这些可解释性工具可以提前发现其中一些关联和歧义,以帮助从业人员预防潜在问题。

[1]请注意,发布的CLIP模型仅用于研究目的。请参阅相关的型号卡。

OpenAL对CLIP的理解仍在进行中,是否会发布以及如何发布大型CLIP仍在讨论中。研究人员希望大家对已发布的版本和工具进行进一步的探索,这不仅有助于增进对多模态系统的理解,也能为人类自己的决策提供信息。

总结

除了本文的发布,OpenAI还发布了一些他们用来理解CLIP的工具——OpenAI Microscope中目录已更新,其中包含CLIP RN50x4中每个神经元的特征可视化、数据集示例和文本特征可视化。OpenAI还将发布CLIP RN50x4和RN101的权重,以进一步进行此类研究。OpenAI的研究人员相信目前对CLIP行为的理解的研究仅仅是以升量石,OpenAI欢迎各种学术组织的加入以推动对CLIP及类似模型的理解的研究。

OpenAI Microscope

https://microscope.openai.com/models

CLIP RN50x4

https://github.com/openai/CLIP

论文链接:

https://distill.pub/2021/multimodal-neurons/

代码链接:

https://github.com/openai/CLIP-featurevis

脚注

[1]请注意,发布的CLIP模型仅用于研究目的。请参阅相关的型号卡。

https://github.com/openai/CLIP/blob/main/model-card.md

引用

1. Quiroga, R. Q., Reddy, L., Kreiman, G., Koch, C., & Fried, I. (2005). Invariant visual epresentation by single neurons in the human brain. Nature, 435(7045), 1102-1107.

https://www.nature.com/articles/nature03687

2. He, K., Zhang, X., Ren, S., & Sun, J. (2016). Deep residual learning for image recognition. In Proceedings of the IEEE conference on computer vision and pattern recognition (pp. 770-778).

https://openaccess.thecvf.com/content_cvpr_2016/papers/He_Deep_Residual_Learning_CVPR_2016_paper.pdf

3. Erhan, D., Bengio, Y., Courville, A., & Vincent, P. (2009). Visualizing higher-layer features of a deep network. University of Montreal, 1341(3), 1.

https://www.researchgate.net/profile/Aaron_Courville/publication/265022827_Visualizing_Higher-

Layer_Features_of_a_Deep_Network/links/53ff82b00cf24c81027da530.pdf

4. Szegedy, C., Zaremba, W., Sutskever, I., Bruna, J., Erhan, D., Goodfellow, I., & Fergus, R. (2013). Intriguing properties of neural networks. arXiv preprint arXiv:1312.6199.

https://arxiv.org/abs/1312.6199

5. Mahendran, A., & Vedaldi, A. (2014). Understanding Deep Image Representations by Inverting Them. arXiv preprint arXiv:1412.0035.

https://arxiv.org/abs/1412.0035

6. Nguyen, A., Yosinski, J., & Clune, J. (2015). Deep neural networks are easily fooled: High confidence predictions for unrecognizable images. In Proceedings of the IEEE conference on computer vision and pattern recognition (pp. 427-436).

https://www.cv-foundation.org/openaccess/content_cvpr_2015/html/Nguyen_Deep_Neural_Networks_2015_CVPR_paper.html

7. Øygard, A. (2015). Visualizing GoogLeNet Classes. Accessed in.

https://www.auduno.com/2015/07/29/visualizing-googlenet-classes/

8. Mordvintsev, A., Olah, C., & Tyka, M. (2015). Inceptionism: Going deeper into neural networks.

https://ai.googleblog.com/2015/06/inceptionism-going-deeper-into-neural.html

9. Nguyen, A., Dosovitskiy, A., Yosinski, J., Brox, T., & Clune, J. (2016). Synthesizing the preferred inputs for neurons in neural networks via deep generator networks. arXiv preprint arXiv:1605.09304.

https://arxiv.org/abs/1605.09304

10. Nguyen, A., Clune, J., Bengio, Y., Dosovitskiy, A., & Yosinski, J. (2017). Plug & play generative networks: Conditional iterative generation of images in latent space. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (pp. 4467-4477).

http://openaccess.thecvf.com/content_cvpr_2017/html/Nguyen_Plug__Play_CVPR_2017_paper.html

11. Nguyen, A., Yosinski, J., & Clune, J. (2016). Multifaceted feature visualization: Uncovering the different types of features learned by each neuron in deep neural networks. arXiv preprint arXiv:1602.03616.

https://arxiv.org/abs/1602.03616

12. Olah, C., Mordvintsev, A., & Schubert, L. (2017). Feature visualization. Distill, 2(11), e7.

https://distill.pub/2017/feature-visualization

13. Goh, G., et al. (2021). Multimodal Neurons in Artificial Neural Networks. Distill.

https://mp.weixin.qq.com/cgi-bin/appmsg?t=media/appmsg_edit_v2&action=edit&isNew=1&type=10&createType=0&token=395857631&lang=zh_CN#imagenet-challenge

14. Miller, G. A. (1995). WordNet: a lexical database for English. Communications of the ACM, 38(11), 39-41.

https://dl.acm.org/doi/abs/10.1145/219717.219748

15. Crawford, K. & Paglen, T. (2019). Excavating AI: the politics of images in machine learning training sets. Excavating AI.

https://excavating.ai/

16. Hanna, A., Denton, E., Amironesei, R,, Smart A., Nicole, H. Lines of Sight. Logic Magazine.

https://logicmag.io/commons/lines-of-sight/

17. Fried, I., MacDonald, K. A., & Wilson, C. L. (1997). Single neuron activity in human hippocampus and amygdala during recognition of faces and objects. Neuron, 18(5), 753-765.

https://www.sciencedirect.com/science/article/pii/S0896627300803153

18. Kreiman, G., Koch, C., & Fried, I. (2000). Category-specific visual responses of single neurons in the human medial temporal lobe. Nature neuroscience, 3(9), 946-953.

https://www.nature.com/articles/nn0900_946

19. Radford, A., Jozefowicz, R., & Sutskever, I. (2017). Learning to generate reviews and discovering sentiment. arXiv preprint arXiv:1704.01444.

https://arxiv.org/abs/1704.01444

20. Mikolov, T., Chen, K., Corrado, G., & Dean, J. (2013). Efficient estimation of word representations in vector space. arXiv preprint arXiv:1301.3781.

https://arxiv.org/abs/1301.3781

21. Brown, T. B., Mané, D., Roy, A., Abadi, M., & Gilmer, J. (2017). Adversarial patch. arXiv preprint arXiv:1712.09665.

https://arxiv.org/abs/1712.09665

22. Crawford, K. & Paglen, T. (2019). Excavating AI: the politics of images in machine learning training sets. Excavating AI.

https://excavating.ai/

编辑:王菁

校对:林亦霖

译者简介

欧阳锦,我是一名即将去埃因霍芬理工大学继续攻读数据科学专业的硕士生。本科毕业于华北电力大学,自己喜欢的科研方向是隐私安全中的数据科学算法。有很多爱好和兴趣(摄影、运动、音乐),对生活中的事情充满兴趣,是个热爱钻研、开朗乐观的人。为了更好地学习自己喜欢的专业领域,希望能够接触到更多相关的事物以开拓自己的眼界和思路。

翻译组招募信息

工作内容:需要一颗细致的心,将选取好的外文文章翻译成流畅的中文。如果你是数据科学/统计学/计算机类的留学生,或在海外从事相关工作,或对自己外语水平有信心的朋友欢迎加入翻译小组。

你能得到:定期的翻译培训提高志愿者的翻译水平,提高对于数据科学前沿的认知,海外的朋友可以和国内技术应用发展保持联系,THU数据派产学研的背景为志愿者带来好的发展机遇。

其他福利:来自于名企的数据科学工作者,北大清华以及海外等名校学生他们都将成为你在翻译小组的伙伴。

点击文末“阅读原文”加入数据派团队~

转载须知

如需转载,请在开篇显著位置注明作者和出处(转自:数据派ID:DatapiTHU),并在文章结尾放置数据派醒目二维码。有原创标识文章,请发送【文章名称-待授权公众号名称及ID】至联系邮箱,申请白名单授权并按要求编辑。

发布后请将链接反馈至联系邮箱(见下方)。未经许可的转载以及改编者,我们将依法追究其法律责任。

点击“阅读原文”拥抱组织