机器之心报道

机器之心编辑部

进NLP群—>加入NLP交流群

了解当代大型语言模型背后的设计、约束和演变,你可以遵循本文的阅读清单。

大型语言模型已经引起了公众的注意,短短五年内,Transforme等模型几乎完全改变了自然语言处理领域。此外,它们还开始在计算机视觉和计算生物学等领域引发革命。

鉴于Transformers对每个人的研究进程都有如此大的影响,本文将为大家介绍一个简短的阅读清单,供机器学习研究人员和从业者入门使用。

下面的列表主要是按时间顺序展开的,主要是一些学术研究论文。当然,还有许多其他有用的资源。例如:

Jay Alammar撰写的《The Illustrated Transformer》

Lilian Weng撰写的《The Transformer Family》

Xavier Amatriain撰写的《Transformer models: an introduction and catalog — 2023 Edition》

Andrej Karpathy写的nanoGPT库

对主要架构和任务的理解

如果你是Transformers、大型语言模型新手,那么这几篇文章最适合你。

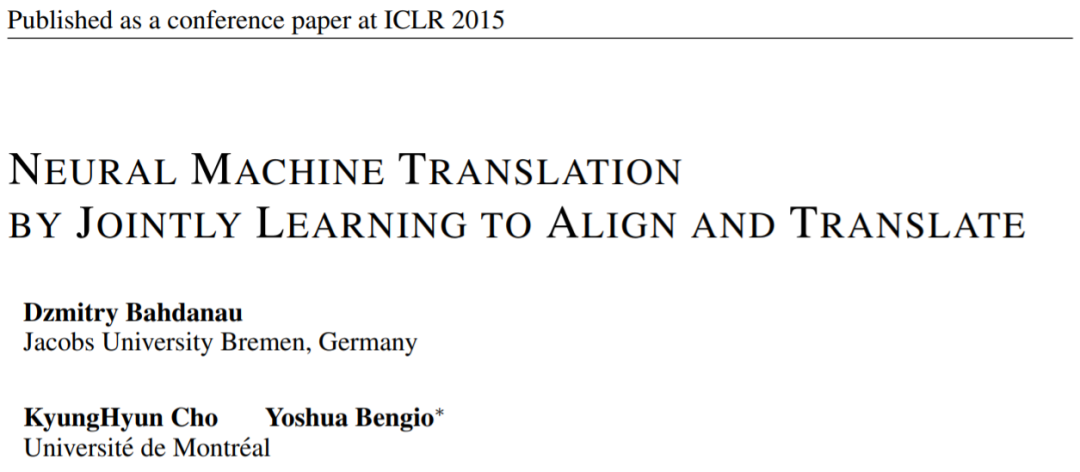

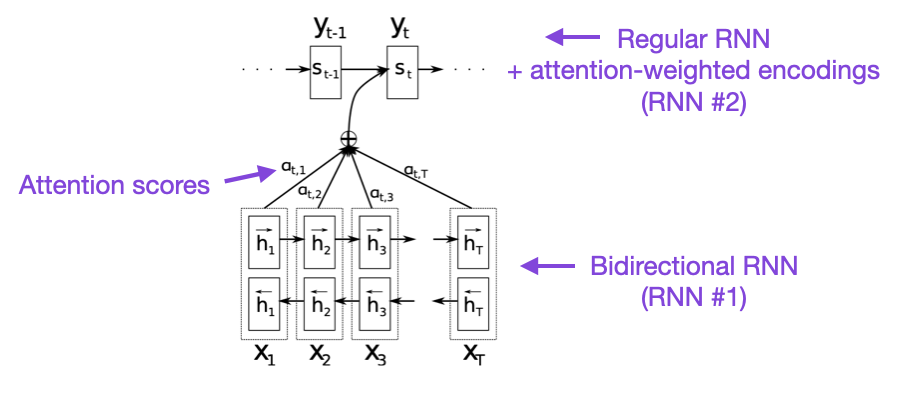

论文1:《Neural Machine Translation by Jointly Learning to Align and Translate》

论文地址:https://arxiv.org/pdf/1409.0473.pdf

本文引入了一种循环神经网络(RNN)注意力机制,提高了模型远程序列建模能力。这使得RNN能够更准确地翻译较长的句子——这也是后来开发原始Transformer架构的动机。

图源: https://arxiv.org/abs/1409.0473

图源: https://arxiv.org/abs/1409.0473

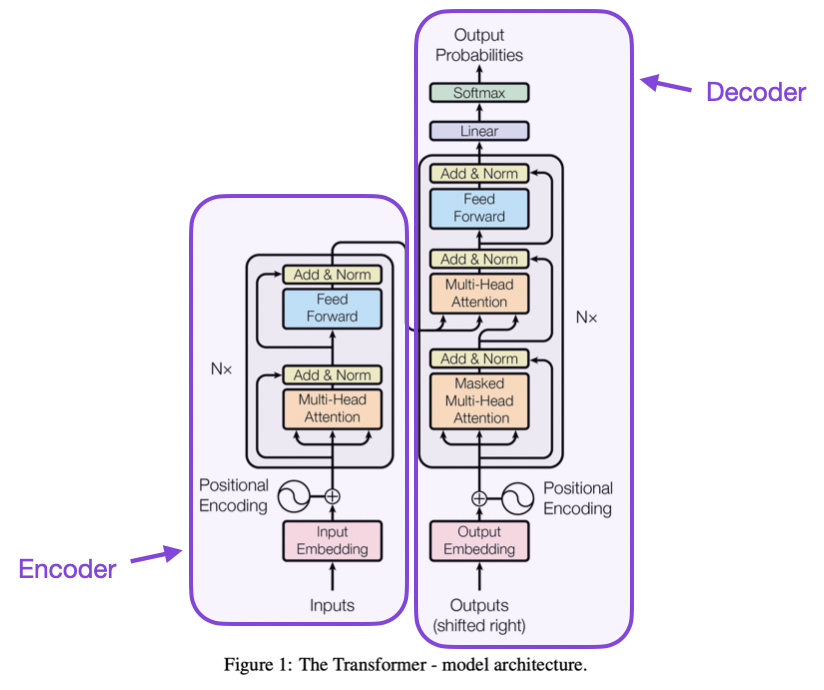

论文2:《Attention Is All You Need》

论文地址:https://arxiv.org/abs/1706.03762

本文介绍了由编码器和解码器组成的原始Transformer架构,这些部分将在以后作为单独模块进行相关介绍。此外,本文还介绍了缩放点积注意力机制、多头注意力块和位置输入编码等概念,这些概念仍然是现代Transformer的基础。

图源:https://arxiv.org/abs/1706.03762

论文3:《BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding》

论文地址:https://arxiv.org/abs/1810.04805

大型语言模型研究遵循最初的Transformer架构,然后开始向两个方向延伸:用于预测建模任务(如文本分类)的Transformer和用于生成建模任务(如翻译、摘要和其他形式的文本创建)的Transformer 。

BERT论文介绍了掩码语言建模原始概念,如果你对这个研究分支感兴趣,那么可以跟进RoBERTa,其简化了预训练目标。

图源:https://arxiv.org/abs/1810.04805

图源:https://arxiv.org/abs/1810.04805

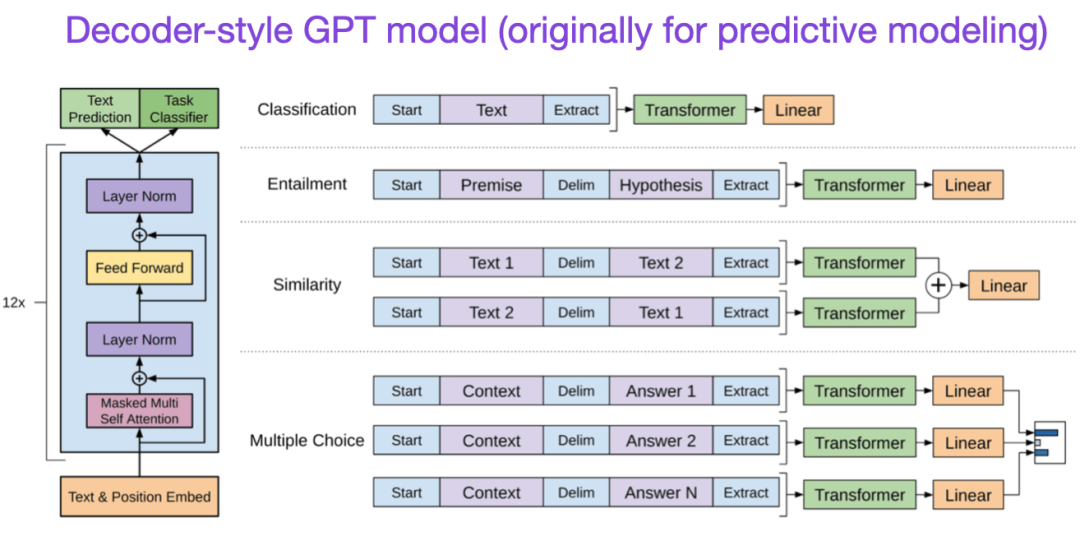

论文4:《Improving Language Understanding by Generative Pre-Training》

论文地址:https://www.semanticscholar.org/paper/Improving-Language-Understanding-by-Generative-Radford-Narasimhan/cd18800a0fe0b668a1cc19f2ec95b5003d0a5035

最初的GPT论文介绍了流行的解码器风格的架构和通过下一个单词预测进行预训练。BERT由于其掩码语言模型预训练目标,可以被认为是一个双向Transformer,而GPT是一个单向自回归模型。虽然GPT嵌入也可以用于分类,但GPT方法是当今最有影响力的LLMs(如ChatGPT)的核心。

如果你对这个研究分支感兴趣,那么可以跟进GPT-2和GPT-3的论文。此外,本文将在后面单独介绍InstructGPT方法。

论文5:《BART: Denoising Sequence-to-Sequence Pre-training for Natural Language Generation, Translation, and Comprehension》

论文地址 https://arxiv.org/abs/1910.13461.

如上所述, BERT型编码器风格的LLM通常是预测建模任务的首选,而GPT型解码器风格的LLM更擅长生成文本。为了两全其美,上面的BART论文结合了编码器和解码器部分。

扩展定律与效率提升

如果你想了解更多关于提高Transformer效率的技术,可以参考以下论文

论文1:《A Survey on Efficient Training of Transformers》

论文地址:https://arxiv.org/abs/2302.01107

论文2:《FlashAttention: Fast and Memory-Efficient Exact Attention with IO-Awareness》

论文地址:https://arxiv.org/abs/2205.14135

论文3:《Cramming: Training a Language Model on a Single GPU in One Day》

论文地址:https://arxiv.org/abs/2212.14034

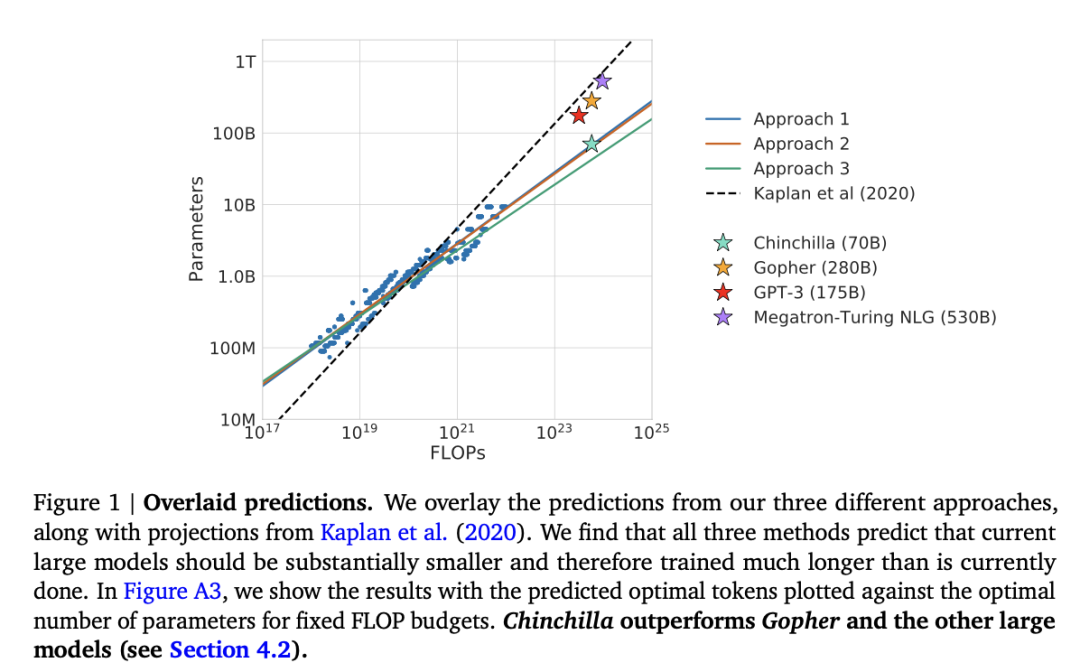

论文4:《Training Compute-Optimal Large Language Models》

论文地址:https://arxiv.org/abs/2203.15556

此外,还有论文《Training Compute-Optimal Large Language Models》

论文地址:https://arxiv.org/abs/2203.15556

本文介绍了700亿参数的Chinchilla模型,该模型在生成建模任务上优于流行的1750亿参数的GPT-3模型。然而,它的主要点睛之处在于,当代大型语言模型训练严重不足。

本文定义了用于大型语言模型训练的线性scaling law。例如,虽然Chinchilla的大小只有GPT-3的一半,但它的表现优于GPT-3,因为它是在1.4万亿(而不是3000亿)token上进行训练的。换句话说,训练token的数量和模型大小一样重要。

对齐——将大型语言模型朝着预期的目标和兴趣引导

近年来出现了许多相对强大的大型语言模型,它们可以生成真实的文本(例如GPT-3和Chinchilla)。就常用的预训练范式而言,目前似乎已经达到了一个上限。

为了使语言模型更能帮助到人类,减少错误信息和不良语言,研究人员设计了额外的训练范式来微调预训练的基础模型,包括如下论文。

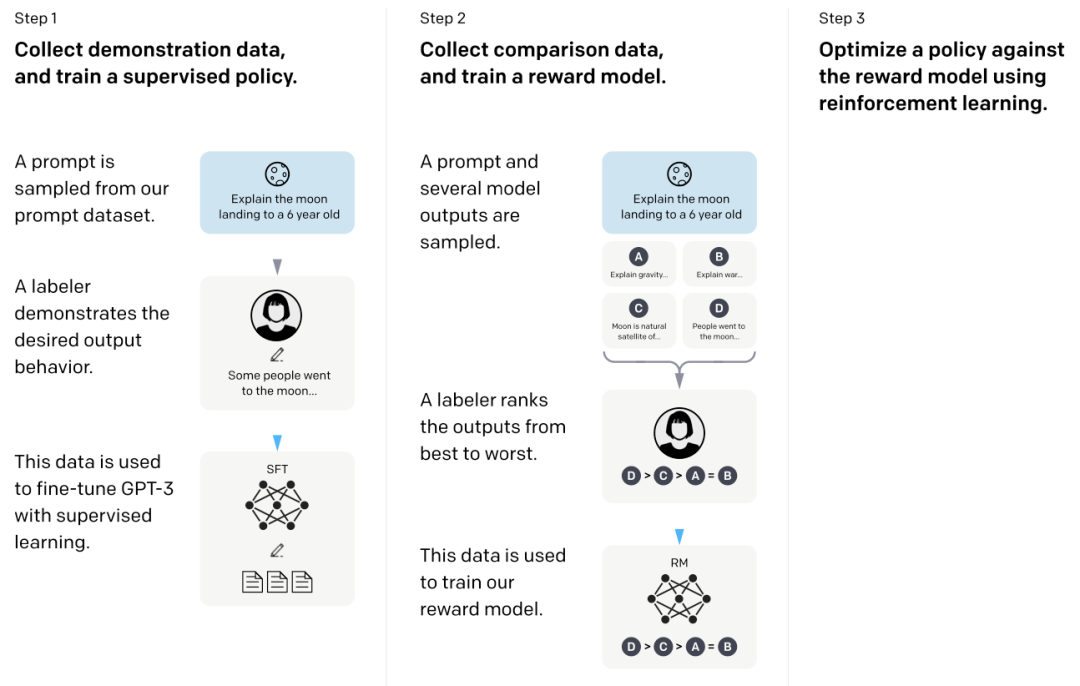

论文1:《Training Language Models to Follow Instructions with Human Feedback》

论文地址:https://arxiv.org/abs/2203.02155

在这篇所谓的InstructGPT论文中,研究人员使用了RLHF(Reinforcement Learning from Human Feedback)。他们从预训练的GPT-3基础模型开始,并使用监督学习对人类生成的提示响应对进行进一步微调(步骤1)。接下来,他们要求人类对模型输出进行排序以训练奖励模型(步骤2)。最后,他们使用奖励模型通过近端策略优化(步骤3)使用强化学习来更新预训练和微调的GPT-3模型。

顺便说一句,这篇论文也被称为描述ChatGPT背后思想的论文——根据最近的传言,ChatGPT是InstructGPT的扩展版本,它在更大的数据集上进行了微调。

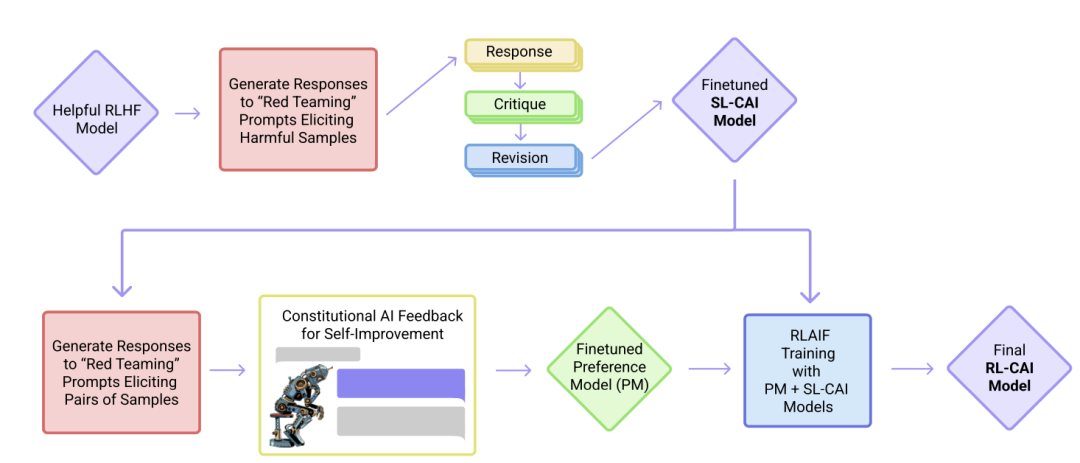

论文2:《Constitutional AI: Harmlessness from AI Feedback》

论文地址:https://arxiv.org/abs/2212.08073

在这篇论文中,研究人员进一步推进了对齐的想法,提出了一种创建「harmless」的AI系统的训练机制。研究人员提出了一种基于规则列表(由人类提供)的自训练机制,而不是直接由人类监督。与上面提到的InstructGPT论文类似,所提出的方法使用了强化学习方法。

总结

本文对上方表单的排列尽量保持简洁美观,建议重点关注前10篇论文,以了解当代大型语言模型背后的设计、局限和演变。

如果想深入阅读,建议参考上述论文中的参考文献。或者,这里有一些额外的资源,供读者进一步研究:

GPT的开源替代方案

论文1:《BLOOM: A 176B-Parameter Open-Access Multilingual Language Model》

论文地址:https://arxiv.org/abs/2211.05100

论文2:《OPT: Open Pre-trained Transformer Language Models》

论文地址:https://arxiv.org/abs/2205.01068

ChatGPT的替代方案

论文1《LaMDA: Language Models for Dialog Applications》

论文地址:https://arxiv.org/abs/2201.08239

论文2:《Improving alignment of dialogue agents via targeted human judgements》

论文地址:https://arxiv.org/abs/2209.14375

论文3:《BlenderBot 3: a deployed conversational agent that continually learns to responsibly engage》

论文地址:https://arxiv.org/abs/2208.03188

计算生物学中的大型语言模型

论文1:《 ProtTrans: Towards Cracking the Language of Life’s Code Through Self-Supervised Learning 》

论文地址:https://arxiv.org/abs/2007.06225

论文2:《Highly accurate protein structure prediction with AlphaFold》

论文地址:https://www.nature.com/articles/s41586-021-03819-2

论文3:《Large Language Models Generate Functional Protein Sequences Across Diverse Families》

论文地址:https://www.nature.com/articles/s41587-022-01618-2

原文链接:https://sebastianraschka.com/blog/2023/llm-reading-list.html

知识星球:NLP学术交流与求职群

持续发布自然语言处理NLP每日优质论文解读、相关一手资料、AI算法岗位等最新信息。

加入星球,你将获得:

1. 最新最优质的论文速读。用几秒钟就可掌握论文大致内容,包含论文一句话总结、大致内容、研究方向以及pdf下载等。

2. 最新入门和进阶学习资料。包含机器学习、深度学习、NLP等领域。

3. 具体细分NLP方向包括不限于:情感分析、关系抽取、知识图谱、句法分析、语义分析、机器翻译、人机对话、文本生成、命名实体识别、指代消解、大语言模型、零样本学习、小样本学习、代码生成、多模态、知识蒸馏、模型压缩、AIGC、PyTorch、TensorFlow等细方向。

4. NLP、搜广推、CV等AI岗位招聘信息。可安排模拟面试。